Google è solo l’ultimo a fondere grandi modelli linguistici con i robot. La tendenza ha grandi implicazioni.

Mercoledì scorso Google ha fatto un annuncio alquanto sorprendente. Ha lanciato una versione del suo modello di intelligenza artificiale, Gemini, in grado di operare non solo nel regno digitale dei chatbot e della ricerca su Internet, ma anche nel mondo fisico, attraverso i robot.

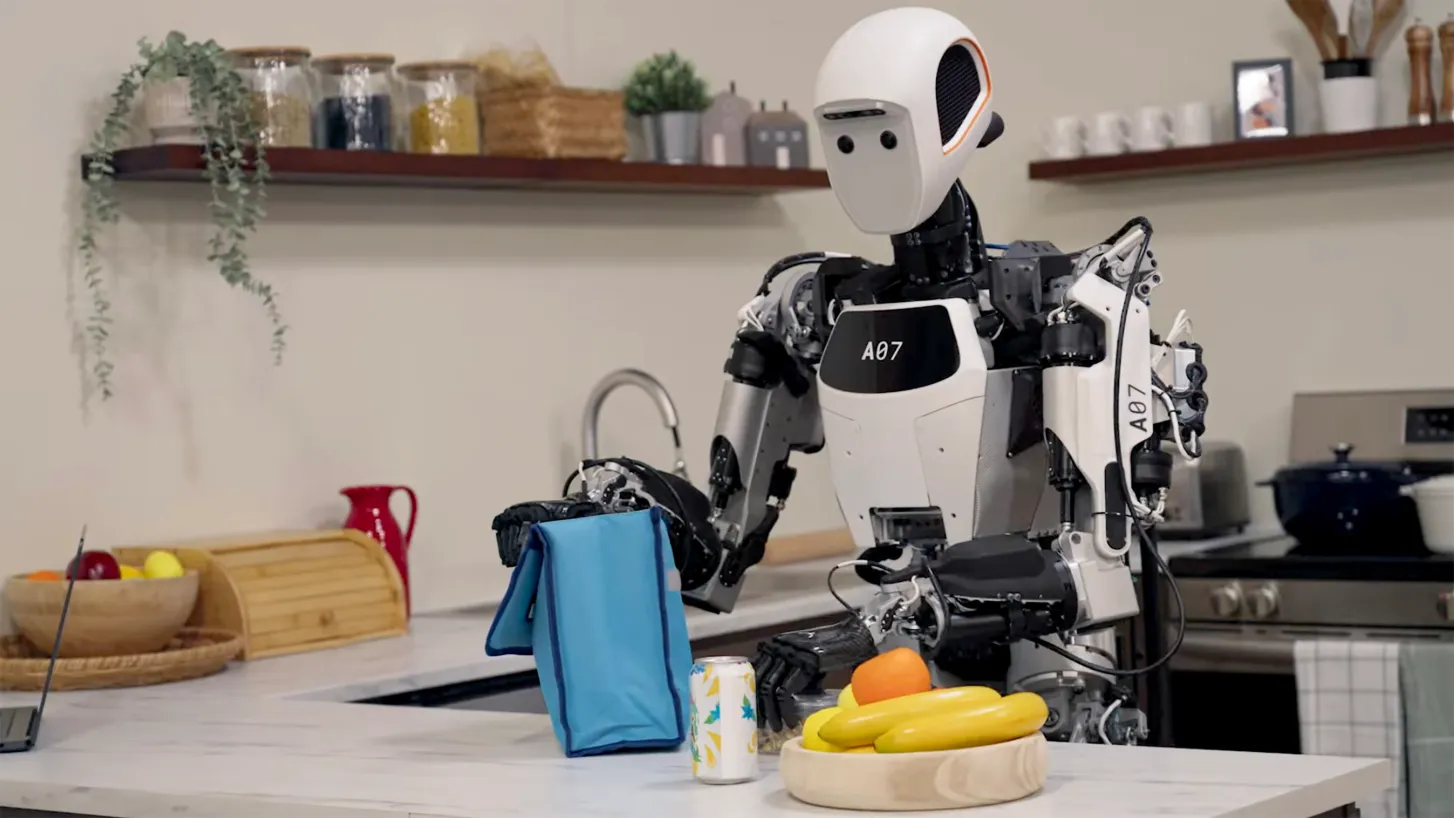

Gemini Robotics fonde la potenza dei modelli linguistici di grandi dimensioni con il ragionamento spaziale, consentendo di dire a un braccio robotico di fare qualcosa come “metti l’uva nella ciotola di vetro trasparente”. Questi comandi vengono filtrati dall’LLM, che identifica le intenzioni in base a ciò che dite e le scompone in comandi che il robot può eseguire. Per maggiori dettagli su come funziona il tutto, leggete l’articolo completo del mio collega Scott Mulligan.

Vi starete chiedendo se questo significhi che un giorno la vostra casa o il vostro posto di lavoro saranno pieni di robot a cui potrete abbaiare ordini. Ne riparleremo presto.

Ma prima di tutto, da dove nasce questo progetto? Finora Google non ha fatto grandi passi avanti nel mondo della robotica. Nell’ultimo decennio Alphabet ha acquisito alcune startup di robotica, ma nel 2023 ha chiuso un’unità che lavorava su robot per risolvere compiti pratici come la pulizia dei rifiuti.

Ciononostante, la mossa dell’azienda di portare l’intelligenza artificiale nel mondo fisico attraverso i robot segue l’esatto precedente stabilito da altre aziende negli ultimi due anni (qualcosa che, devo umilmente sottolineare, MIT Technology Review ha visto arrivare da tempo).

In breve, due tendenze stanno convergendo da direzioni opposte: le aziende di robotica sfruttano sempre più l’IA e i giganti dell’IA stanno costruendo robot. OpenAI, ad esempio, che ha chiuso il suo team di robotica nel 2021, ha iniziato quest’anno un nuovo sforzo per costruire robot umanoidi. In ottobre, il gigante dei chip Nvidia ha dichiarato che la prossima ondata di intelligenza artificiale sarà l'”IA fisica”.

Ci sono molti modi per incorporare l’intelligenza artificiale nei robot, a partire dal miglioramento del modo in cui vengono addestrati a svolgere i compiti. Ma l’utilizzo di modelli linguistici di grandi dimensioni per dare istruzioni, come ha fatto Google, è particolarmente interessante.

Non è la prima volta. La startup di robotica Figure è diventata virale un anno fa per un video in cui gli esseri umani davano istruzioni a un umanoide su come mettere a posto i piatti. Più o meno nello stesso periodo, una startup nata da OpenAI, chiamata Covariant, ha realizzato qualcosa di simile per i bracci robotici nei magazzini. Ho visto una dimostrazione in cui si potevano dare al robot istruzioni tramite immagini, testo o video per fare cose come “spostare le palline da tennis da questo cestino a quello”. Covariant è stata acquisita da Amazon solo cinque mesi dopo.

Quando si vedono queste dimostrazioni, non si può fare a meno di chiedersi: Quando arriveranno questi robot nei nostri luoghi di lavoro? E nelle nostre case?

Se i piani di Figure offrono un indizio, la risposta alla prima domanda è imminente. Sabato l’azienda ha annunciato la costruzione di un impianto di produzione ad alto volume in grado di produrre 12.000 robot umanoidi all’anno. Ma l’addestramento e il collaudo dei robot, soprattutto per garantire la loro sicurezza nei luoghi in cui lavorano vicino agli esseri umani, richiedono molto tempo ancora .

Ad esempio, la concorrente Agility Robotics di Figure sostiene di essere l’unica azienda negli Stati Uniti ad avere clienti paganti per i suoi umanoidi. Ma gli standard di sicurezza del settore per gli umanoidi che lavorano a fianco delle persone non sono ancora del tutto definiti, quindi i robot dell’azienda devono lavorare in aree separate.

Ecco perché, nonostante i recenti progressi, le nostre case saranno l’ultima frontiera. Rispetto alle fabbriche, le nostre case sono caotiche e imprevedibili. Tutti sono stipati in ambienti relativamente vicini. Anche i modelli di intelligenza artificiale più impressionanti, come Gemini Robotics, dovranno essere sottoposti a numerosi test sia nel mondo reale che in simulazione, proprio come le auto a guida autonoma. I test potrebbero svolgersi in magazzini, hotel e ospedali, dove i robot potrebbero ancora ricevere l’aiuto di operatori umani remoti. Ci vorrà molto tempo prima che abbiano il privilegio di mettere a posto i nostri piatti.