I rischi che comporta il legame che si instaura tra i bambini e i chatbot hanno trasformato la sicurezza dell’intelligenza artificiale da una preoccupazione astratta a un tema politico scottante. Cosa succederà adesso?

Da quando esiste l’intelligenza artificiale, ci sono persone che lanciano allarmi su ciò che potrebbe causarci: superintelligenza ribelle, disoccupazione di massa o rovina ambientale dovuta alla proliferazione dei data center. Ma questa settimana abbiamo avuto la dimostrazione che un’altra minaccia completamente diversa, quella dei bambini che instaurano legami malsani con l’intelligenza artificiale, sta portando la sicurezza dell’intelligenza artificiale fuori dalla nicchia accademica e sotto il mirino delle autorità di regolamentazione.

La questione è in fermento da tempo. Due cause legali di alto profilo intentate lo scorso anno contro Character.AI e OpenAI sostengono che il comportamento simile a quello di un compagno nei loro modelli abbia contribuito al suicidio di due adolescenti. Uno studio condotto dall’organizzazione no profit statunitense Common Sense Media, pubblicato a luglio, ha rilevato che il 72% degli adolescenti ha utilizzato l’IA come compagnia. Articoli pubblicati da testate autorevoli sulla “psicosi da IA” hanno evidenziato come le conversazioni infinite con i chatbot possano portare le persone a cadere in spirali deliranti.

È difficile sopravvalutare l’impatto di queste notizie. Per l’opinione pubblica, sono la prova che l’IA non è solo imperfetta, ma è una tecnologia più dannosa che utile. Se dubitavate che questa indignazione sarebbe stata presa sul serio dalle autorità di regolamentazione e dalle aziende, questa settimana sono successe tre cose che potrebbero farvi cambiare idea.

Una legge californiana viene approvata dal legislatore

Giovedì, il legislatore dello Stato della California ha approvato una legge senza precedenti. Essa richiederebbe alle aziende di IA di includere dei promemoria per gli utenti che sanno essere minorenni, ricordando loro che le risposte sono generate dall’IA. Le aziende dovrebbero inoltre dotarsi di un protocollo per affrontare il suicidio e l’autolesionismo e fornire relazioni annuali sui casi di ideazione suicidaria nelle conversazioni degli utenti con i loro chatbot. Il disegno di legge è stato presentato dal senatore democratico Steve Padilla, approvato con un forte sostegno bipartisan e ora attende la firma del governatore Gavin Newsom.

Ci sono motivi per essere scettici sull’impatto del disegno di legge. Esso non specifica gli sforzi che le aziende dovrebbero compiere per identificare quali utenti sono minorenni, e molte aziende di IA includono già riferimenti a fornitori di servizi di crisi quando qualcuno parla di suicidio. (Nel caso di Adam Raine, uno degli adolescenti i cui familiari hanno intentato causa, le sue conversazioni con ChatGPT prima della sua morte includevano questo tipo di informazioni, ma il chatbot avrebbe comunque continuato a dare consigli relativi al suicidio).

Tuttavia, si tratta indubbiamente dello sforzo più significativo per frenare i comportamenti simili a quelli di un compagno nei modelli di IA, che sono in fase di elaborazione anche in altri stati. Se il disegno di legge diventasse legge, sarebbe un duro colpo alla posizione assunta da OpenAI, secondo cui “l’America è leader grazie a regole chiare a livello nazionale, non a un mosaico di regolamenti statali o locali”, come ha scritto la scorsa settimana su LinkedIn il responsabile degli affari globali dell’azienda, Chris Lehane.

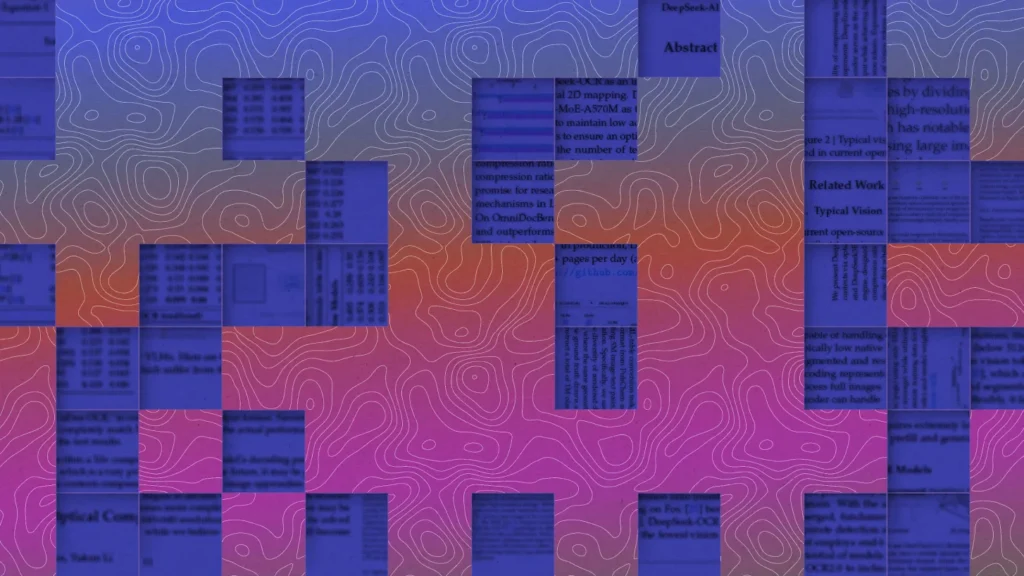

La Federal Trade Commission prende di mira

Lo stesso giorno, la Federal Trade Commission ha annunciato un’indagine su sette aziende, alla ricerca di informazioni su come sviluppano personaggi simili a compagni, monetizzano il coinvolgimento, misurano e testano l’impatto dei loro chatbot e altro ancora. Le aziende sono Google, Instagram, Meta, OpenAI, Snap, X e Character Technologies, il produttore di Character.AI.

La Casa Bianca esercita ora un’enorme influenza politica, potenzialmente illegale, sull’agenzia. A marzo, il presidente Trump ha licenziato l’unica commissaria democratica, Rebecca Slaughter. A luglio, un giudice federale ha dichiarato illegale il licenziamento, ma la scorsa settimana la Corte Suprema degli Stati Uniti lo ha temporaneamente autorizzato.

“Proteggere i bambini online è una priorità assoluta per la FTC di Trump-Vance, così come lo è promuovere l’innovazione in settori critici della nostra economia”, ha dichiarato il presidente della FTC Andrew Ferguson in un comunicato stampa sull’indagine.

Al momento si tratta solo di un’indagine, ma il processo potrebbe (a seconda di quanto la FTC renderà pubblici i suoi risultati) rivelare i meccanismi interni con cui le aziende costruiscono i loro compagni di intelligenza artificiale per fidelizzare gli utenti.

Sam Altman sui casi di suicidio

Sempre lo stesso giorno (una giornata intensa per le notizie sull’IA), Tucker Carlson ha pubblicato un’intervista di un’ora con il CEO di OpenAI, Sam Altman. L’intervista copre molti argomenti: la battaglia di Altman con Elon Musk, i clienti militari di OpenAI, le teorie del complotto sulla morte di un ex dipendente, ma include anche i commenti più sinceri che Altman abbia fatto finora sui casi di suicidio seguiti a conversazioni con l’IA.

Altman ha parlato della “tensione tra la libertà e la privacy degli utenti e la protezione degli utenti vulnerabili” in casi come questi. Ma poi ha detto qualcosa che non avevo mai sentito prima.

“Penso che sarebbe molto ragionevole da parte nostra dire che nei casi in cui i giovani parlano seriamente di suicidio e non riusciamo a contattare i genitori, chiamiamo le autorità”, ha detto. “Sarebbe un cambiamento”.

Quindi, quale sarà il prossimo passo? Per ora, è chiaro che, almeno nel caso dei bambini danneggiati dalla compagnia dell’IA, il solito copione delle aziende non funzionerà. Non possono più eludere le loro responsabilità appellandosi alla privacy, alla personalizzazione o alla “scelta dell’utente”. La pressione per adottare una linea più dura sta aumentando da parte delle leggi statali, delle autorità di regolamentazione e di un pubblico indignato.

Ma come si concretizzerà tutto questo? Dal punto di vista politico, sia la sinistra che la destra stanno ora prestando attenzione ai danni causati dall’IA ai bambini, ma le loro soluzioni sono diverse. A destra, la soluzione proposta è in linea con l’ondata di leggi sull’età minima per l’accesso a Internet che sono state approvate in oltre 20 Stati. Queste leggi hanno lo scopo di proteggere i bambini dai contenuti per adulti, difendendo al contempo i “valori familiari”. A sinistra, si tratta della rinascita delle ambizioni, finora rimaste in sospeso, di ritenere le grandi aziende tecnologiche responsabili attraverso i poteri antitrust e di tutela dei consumatori.

È più facile raggiungere un consenso sul problema che un accordo sulla cura. Allo stato attuale, sembra probabile che finiremo con un mosaico di regolamenti statali e locali contro cui OpenAI (e molti altri) hanno fatto pressioni.

Per ora, spetta alle aziende decidere dove tracciare i confini. Devono decidere cose come: i chatbot dovrebbero interrompere le conversazioni quando gli utenti tendono all’autolesionismo, o questo peggiorerebbe la situazione di alcune persone? Dovrebbero essere autorizzati e regolamentati come i terapeuti o trattati come prodotti di intrattenimento con avvertenze? L’incertezza deriva da una contraddizione di fondo: le aziende hanno creato chatbot che si comportano come esseri umani premurosi, ma hanno rinviato lo sviluppo degli standard e delle responsabilità che esigiamo dai veri caregiver. Il tempo sta per scadere.