L’idea che le macchine saranno intelligenti quanto gli esseri umani, o addirittura più intelligenti, ha conquistato un intero settore. Ma guardando più da vicino, ci si rende conto che si tratta di un mito che persiste per molte delle stesse ragioni per cui persistono le teorie del complotto.

Lo sentite anche voi?

Ho sentito dire che è vicina: due anni, cinque anni, forse già l’anno prossimo! E ho sentito dire che cambierà tutto: curerà le malattie, salverà il pianeta e inaugurerà un’era di abbondanza. Risolverà i nostri problemi più grandi in modi che non possiamo ancora immaginare. Ridefinirà il significato stesso di essere umani.

Aspetta… e se fosse troppo bello per essere vero? Perché ho anche sentito dire che porterà l’apocalisse e ci ucciderà tutti…

In ogni caso, e qualunque sia la vostra linea temporale, sta per accadere qualcosa di grande.

Potremmo parlare della Seconda Venuta. O del giorno in cui i Heaven’s Gaters immaginavano di essere prelevati da un UFO e trasformati in alieni illuminati. O del momento in cui Donald Trump decide finalmente di scatenare la tempesta promessa da Q. Ma no. Stiamo ovviamente parlando dell’intelligenza artificiale generale, o AGI, quella ipotetica tecnologia del prossimo futuro che (a quanto ho sentito) sarà in grado di fare praticamente tutto ciò che può fare il cervello umano.

Per molti, l’AGI è più di una semplice tecnologia. Nei centri tecnologici come la Silicon Valley, se ne parla in termini mistici. Si dice che Ilya Sutskever, cofondatore ed ex capo scienziato di OpenAI, abbia guidato i cori “Feel the AGI!” durante le riunioni del team. E lui la sente più di molti altri: nel 2024 ha lasciato OpenAI, la cui missione dichiarata è garantire che l’AGI vada a beneficio di tutta l’umanità, per co-fondare Safe Superintelligence, una startup dedicata a capire come evitare una cosiddetta AGI canaglia (o controllarla quando arriverà). La superintelligenza è la nuova moda del momento – l’AGI ma meglio! – introdotta quando il discorso sull’AGI è diventato di dominio pubblico.

Sutskever è anche un esempio delle motivazioni contrastanti che animano molti evangelisti autoproclamati dell’AGI. Ha dedicato la sua carriera a gettare le basi per una tecnologia futura che ora trova terrificante. “Sarà qualcosa di monumentale, sconvolgente: ci sarà un prima e un dopo”, mi ha detto pochi mesi prima di lasciare OpenAI. Quando gli ho chiesto perché avesse reindirizzato i suoi sforzi verso il controllo di quella tecnologia, ha risposto: “Lo faccio per il mio interesse personale. È ovviamente importante che qualsiasi superintelligenza creata da qualcuno non diventi rogue. Ovviamente”.

Non è affatto il solo a nutrire pensieri grandiosi, persino apocalittici.

Ogni epoca ha i suoi credenti, persone con una fede incrollabile che qualcosa di enorme sta per accadere, un prima e un dopo che hanno il privilegio (o la sfortuna) di vivere.

Per noi, si tratta dell’avvento promesso dell’AGI. Le persone sono abituate a sentire che questa o quella cosa sarà la prossima grande novità, afferma Shannon Vallor, che studia l’etica della tecnologia all’Università di Edimburgo. “Prima era l’era dei computer, poi è stata l’era di Internet e ora è l’era dell’IA”, dice. “È normale che ti venga presentato qualcosa e ti venga detto che quella cosa è il futuro. La differenza, ovviamente, è che a differenza dei computer e di Internet, l’AGI non esiste”.

Ed è per questo che percepire l’AGI non è come promuovere la prossima grande novità. C’è qualcosa di più strano in atto. Ecco cosa penso: l’AGI è molto simile a una teoria del complotto, e potrebbe essere la più importante della nostra epoca.

Mi occupo di intelligenza artificiale da oltre un decennio e ho visto l’idea dell’AGI emergere dall’oscurità fino a diventare la narrativa dominante che plasma un intero settore. Quello che un tempo era un sogno irrealizzabile ora sostiene i profitti di alcune delle aziende più preziose al mondo e, quindi, si potrebbe dire, del mercato azionario statunitense. Giustifica gli investimenti vertiginosi nelle nuove centrali elettriche e nei data center che, secondo quanto ci viene detto, sono necessari per realizzare il sogno. Fissate su questa tecnologia ipotetica, le aziende di IA ci stanno vendendo con insistenza.

Basta ascoltare ciò che ci dicono i dirigenti di alcune di queste aziende. L’AGI sarà intelligente come un intero “paese di geni” (Dario Amodei, CEO di Anthropic); darà il via a “un’era di massimo splendore umano, in cui viaggeremo verso le stelle e colonizzeremo la galassia” (Demis Hassabis, CEO di Google DeepMind); “aumenterà enormemente l’abbondanza e la prosperità”, incoraggiando persino le persone a godersi di più la vita e ad avere più figli (Sam Altman, CEO di OpenAI). È un bel prodotto.

O forse no. Non dimentichiamo il rovescio della medaglia, ovviamente. Quando queste persone non stanno promuovendo l’utopia, ci stanno salvando dall’inferno. Nel 2023, Amodei, Hassabis e Altman hanno tutti firmato una dichiarazione di 22 parole che recita: “Mitigare il rischio di estinzione causato dall’IA dovrebbe essere una priorità globale insieme ad altri rischi su scala sociale come le pandemie e la guerra nucleare”. Elon Musk afferma che l’IA ha il 20% di possibilità di annientare gli esseri umani.

“Ho notato di recente che la superintelligenza, che pensavo fosse un concetto da non menzionare assolutamente se si vuole essere presi sul serio in pubblico, viene sbandierata dai CEO delle aziende tecnologiche che apparentemente stanno progettando di realizzarla”, afferma Katja Grace, ricercatrice capo presso AI Impacts, un’organizzazione che interroga i ricercatori di IA sul loro campo. “Penso che sia facile pensare che vada bene così. Dicono anche che ci ucciderà, ma lo dicono ridendo”.

Bisogna ammettere che tutto questo suona un po’ come una teoria complottista. Se si vuole costruire una teoria del complotto, occorrono alcuni elementi: un piano sufficientemente flessibile da sostenere la convinzione anche quando le cose non vanno come previsto; la promessa di un futuro migliore che può essere realizzato solo se i credenti scoprono verità nascoste; e la speranza di salvezza dagli orrori di questo mondo.

L’AGI soddisfa praticamente tutti questi requisiti. Più si approfondisce l’idea, più inizia a sembrare una cospirazione. Ovviamente non lo è, non esattamente. E non sto tracciando questo parallelo per sminuire i risultati molto reali e spesso sbalorditivi ottenuti da molte persone in questo campo, compresi (o soprattutto) i sostenitori dell’AGI.

Ma concentrandoci sugli aspetti che l’AGI ha in comune con le vere cospirazioni, penso che possiamo mettere a fuoco meglio l’intero concetto e rivelarlo per quello che è: un sogno febbrile tecno-utopico (o tecno-distopico, scegliete voi) che ha messo le sue radici in alcune credenze piuttosto radicate che lo rendono difficile da scalfire.

Questo non è solo un provocatorio esperimento mentale. È importante mettere in discussione ciò che ci viene detto sull’AGI perché credere a questa idea non è innocuo. In questo momento, l’AGI è la narrativa più importante nel campo della tecnologia e, in una certa misura, nell’economia globale. Non possiamo dare un senso a ciò che sta accadendo nell’IA senza capire da dove proviene l’idea dell’AGI, perché è così avvincente e come influenza il nostro modo di pensare alla tecnologia in generale.

Capisco, capisco: definire l’AGI una cospirazione non è un’analogia perfetta. Inoltre farà arrabbiare molte persone. Ma seguite il mio ragionamento e vi mostrerò la luce.

Come la Silicon Valley è stata conquistata dall’AGI

Suonava bene

Una tipica teoria del complotto di solito nasce ai margini. Forse sono solo un paio di persone che postano su un forum, raccogliendo “prove”. Forse sono poche persone nel deserto con un binocolo che aspettano di avvistare delle luci brillanti nel cielo. Ma alcune teorie del complotto hanno fortuna, se così si può dire: iniziano a diffondersi più ampiamente, iniziano a diventare un po’ più accettabili, iniziano a influenzare le persone al potere. Forse sono gli UFO (ehm, scusate, “fenomeni aerei non identificati”) che ora vengono discussi formalmente e apertamente nelle udienze governative. Forse è lo scetticismo sui vaccini (sì, un esempio molto più pericoloso) che diventa politica ufficiale. Ed è impossibile ignorare che l’intelligenza artificiale generale abbia seguito una traiettoria piuttosto simile a quella dei suoi fratelli più apertamente cospirazionisti.

Torniamo al 2007, quando l’IA non era sexy e non era cool. Aziende come Amazon e Netflix (che ancora spediva DVD per posta) utilizzavano modelli di apprendimento automatico, proto-organismi dei colossi LLM di oggi, per consigliare film e libri ai clienti. Ma più o meno era tutto lì.

Ben Goertzel aveva piani molto più ambiziosi. Circa un decennio prima, il ricercatore di IA aveva fondato una startup dot-com chiamata Webmind per addestrare quello che considerava una sorta di cervello digitale infantile sui primi passi di Internet. Senza figli, Webmind fallì presto.

Ma Goertzel era una figura influente in una comunità marginale di ricercatori che da anni sognavano di costruire un’intelligenza artificiale simile a quella umana, un programma informatico multiuso in grado di fare molte delle cose che fanno le persone (e di farle meglio). Era una visione che andava ben oltre il tipo di tecnologia che Netflix stava sperimentando.

Goertzel voleva pubblicare un libro che promuovesse questa visione e aveva bisogno di un nome che lo distinguesse dalla banale IA dell’epoca. Un ex dipendente di Webmind di nome Shane Legg suggerì Artificial General Intelligence. Suonava bene.

Qualche anno dopo, Legg ha co-fondato DeepMind con Demis Hassabis e Mustafa Suleyman. Ma per la maggior parte dei ricercatori seri dell’epoca, l’affermazione che un giorno l’intelligenza artificiale avrebbe imitato le capacità umane era un po’ una barzelletta. AGI era una parolaccia, mi ha detto Sutskever. Andrew Ng, fondatore di Google Brain ed ex capo scienziato del gigante tecnologico cinese Baidu, mi ha detto che pensava fosse una follia.

Cosa è successo allora? Il mese scorso ho incontrato Goertzel per chiedergli come un’idea marginale sia passata dall’essere considerata stravagante a diventare comune. “Sono una persona che si occupa di sistemi caotici complessi, quindi non credo di sapere davvero cosa fosse realmente la dinamica non lineare nella memosfera”, ha detto. (Traduzione: è complicato.)

Goertzel ritiene che alcuni fattori abbiano contribuito a rendere mainstream questa idea. Il primo è la Conference on Artificial General Intelligence, un incontro annuale di ricercatori che ha contribuito a organizzare nel 2008, l’anno successivo alla pubblicazione del suo libro. La conferenza era spesso coordinata con i principali incontri accademici mainstream, come la conferenza dell’Association for the Advancement of Artificial Intelligence e la International Joint Conference on Artificial Intelligence. “Se avessi semplicemente pubblicato un libro con quel titolo, AGI, probabilmente sarebbe passato inosservato”, afferma Goertzel. “Ma la conferenza si ripeteva ogni anno, attirando sempre più studenti”.

Il prossimo è Legg, che ha portato il termine con sé alla DeepMind. “Penso che siano stati i primi a parlare di AGI in ambito aziendale mainstream”, afferma Goertzel. “Non era l’argomento principale su cui insistevano, ma Shane e Demis ne parlavano di tanto in tanto. Questo è stato sicuramente un fattore di legittimazione”.

Quando ho parlato per la prima volta con Legg dell’AGI cinque anni fa, mi ha detto: “Parlare di AGI all’inizio degli anni 2000 ti faceva sembrare un pazzo… Anche quando abbiamo avviato DeepMind nel 2010, abbiamo ricevuto un numero incredibile di occhi al cielo durante le conferenze”. Ma nel 2020 il vento era cambiato. “Alcune persone sono a disagio con questo argomento, ma sta uscendo dall’ombra”, mi ha detto.

La terza cosa che Goertzel sottolinea è la sovrapposizione tra i primi evangelisti dell’AGI e i potenti broker della Big Tech. Negli anni tra la chiusura di Webmind e la pubblicazione del libro sull’AGI, Goertzel ha lavorato con Peter Thiel presso l’hedge fund Clarium Capital di Thiel. “Abbiamo parlato molto”, dice Goertzel. Ricorda di aver trascorso una giornata con Thiel al Four Seasons di San Francisco. “Cercavo di convincerlo dell’AGI”, dice Goertzel. “Ma poi ha anche sentito da Eliezer come l’AGI ucciderà tutti”.

Entrano in scena i catastrofisti

Si tratta di Eliezer Yudkowsky, un’altra figura influente che ha fatto almeno quanto Goertzel, se non di più, per promuovere l’idea dell’AGI. Ma a differenza di Goertzel, Yudkowsky ritiene che ci sia un’alta probabilità (il 99,5% è una delle cifre che cita) che lo sviluppo dell’AGI sia una catastrofe.

Nel 2000, Yudkowsky ha co-fondato un’organizzazione di ricerca senza scopo di lucro chiamata Singularity Institute for Artificial Intelligence (in seguito ribattezzata Machine Intelligence Research Institute), che si è dedicata quasi immediatamente alla prevenzione di scenari apocalittici. Thiel è stato uno dei primi benefattori.

All’inizio, le idee di Yudkowsky non hanno avuto molto successo. Ricordiamo che all’epoca l’idea di un’intelligenza artificiale onnipotente, per non parlare di una pericolosa, era pura fantascienza. Ma nel 2014, Nick Bostrom, filosofo dell’Università di Oxford, ha pubblicato un libro intitolato Superintelligence.

“Ha portato alla ribalta il tema dell’AGI”, afferma Goertzel. “Voglio dire, Bill Gates, Elon Musk e molti altri esponenti del settore tecnologico che si occupano di IA hanno letto quel libro e, indipendentemente dal fatto che fossero d’accordo o meno con la sua visione catastrofica, Nick ha ripreso i concetti di Eliezer e li ha presentati in modo molto accettabile”.

“Tutto questo ha dato all’AGI un’immagine di accettabilità”, aggiunge Goertzel. “Piuttosto che essere considerata una pura follia di eccentrici che urlano nel deserto”.

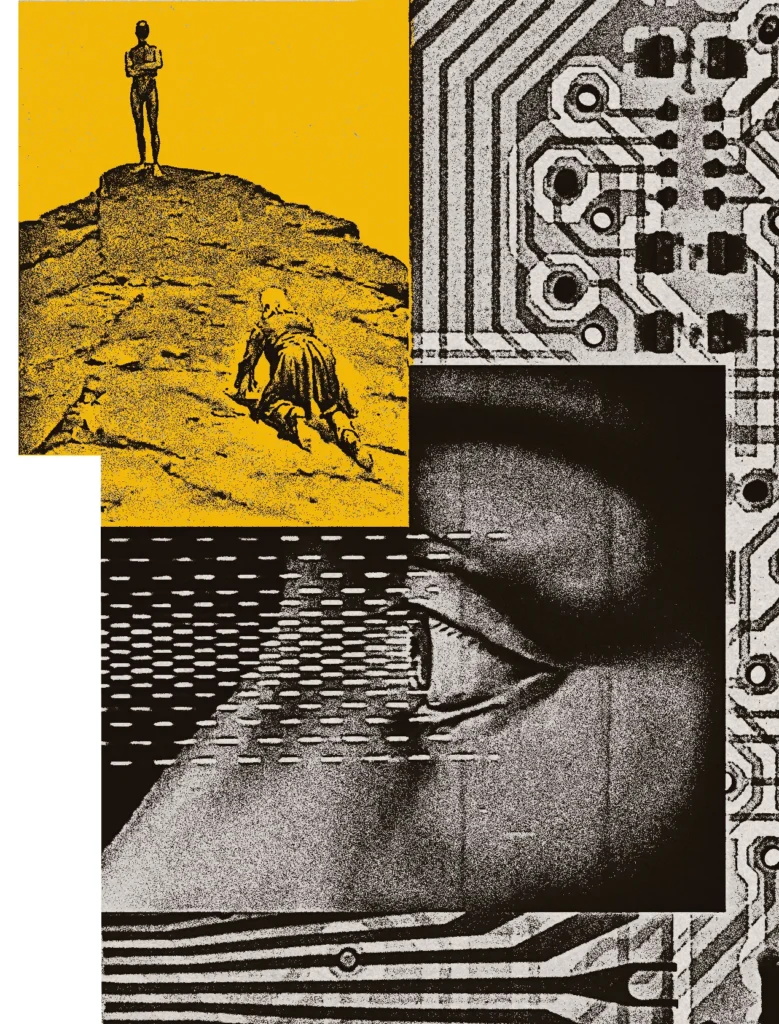

STEPHANIE ARNETT/MIT TECHNOLOGY REVIEW | PUBLIC DOMAIN

Yudkowsky ripete lo stesso concetto da 25 anni; molti ingegneri delle principali aziende di IA di oggi sono cresciuti leggendo e discutendo le sue opinioni online, in particolare su LessWrong, un popolare hub per la fervente comunità di razionalisti e altruisti efficaci del settore tecnologico.

Oggi quelle opinioni sono più popolari che mai e catturano l’immaginazione di una generazione più giovane di pessimisti come David Krueger, ricercatore dell’Università di Montreal che in precedenza ha ricoperto il ruolo di direttore della ricerca presso l’AI Security Institute del Regno Unito. “Penso che siamo decisamente sulla buona strada per costruire sistemi di IA sovrumani che uccideranno tutti”, mi dice Krueger. “E penso che sia orribile e che dovremmo fermarci immediatamente”.

Yudkowsky è stato descritto dal New York Times come “la versione della Silicon Valley di un predicatore dell’apocalisse”. Il suo nuovo libro, If Anyone Builds It, Everyone Dies, scritto insieme a Nate Soares, presidente del Machine Intelligence Research Institute, espone affermazioni azzardate, con poche prove a sostegno, secondo cui, a meno che non interrompiamo lo sviluppo, l’AGI nel prossimo futuro porterà all’Armageddon globale. La posizione dei due è estrema: sostengono che dovrebbe essere applicato un divieto internazionale a tutti i costi, fino al punto di ricorrere alla rappresaglia nucleare. Dopo tutto, “i data center possono uccidere più persone delle armi nucleari”, scrivono Yudkowsky e Soares.

Questo argomento non è più di nicchia. Il libro è un bestseller del New York Times e ha ricevuto il sostegno di esperti di sicurezza nazionale come Suzanne Spaulding, ex funzionaria del Dipartimento della Sicurezza Interna degli Stati Uniti, e Fiona Hill, ex direttrice senior del Consiglio di Sicurezza Nazionale della Casa Bianca, che ora è consulente del governo britannico; scienziati famosi come Max Tegmark e George Church; e altri nomi noti, tra cui Stephen Fry, Mark Ruffalo e Grimes. Yudkowsky ora ha un megafono.

Tuttavia, sono quelle prime parole sussurrate a certe orecchie che potrebbero rivelarsi più significative. A Yudkowsky viene attribuito il merito di aver presentato Thiel ai fondatori di DeepMind, dopo di che Thiel è diventato uno dei primi grandi investitori dell’azienda. Dopo la fusione con Google, ora è il laboratorio interno di IA del colosso tecnologico Alphabet.

Insieme a Musk, Thiel è stato anche determinante nella creazione di OpenAI nel 2015, investendo milioni in una startup fondata con l’ambizione singolare di costruire l’AGI e renderla sicura. Nel 2023, il CEO di OpenAI Sam Altman ha pubblicato su X: “Eliezer ha fatto più di chiunque altro per accelerare l’AGI. Sicuramente ha suscitato l’interesse di molti di noi per l’AGI”. Yudkowsky potrebbe un giorno meritare il Premio Nobel per la Pace per questo, ha aggiunto Altman. Ma a questo punto, Thiel era apparentemente diventato diffidente nei confronti delle “persone che si occupano della sicurezza dell’IA” e del potere che stavano acquisendo. “Non capisci come Eliezer abbia programmato metà delle persone della tua azienda a credere in queste cose”, avrebbe detto ad Altman durante una cena alla fine del 2023. “Devi prendere la cosa più seriamente”. Altman “ha cercato di non alzare gli occhi al cielo”, secondo il giornalista del Wall Street Journal Keach Hagey.

OpenAI è ora l’azienda privata più preziosa al mondo, con un valore di mezzo trilione di dollari.

E la trasformazione è completa: come tutte le cospirazioni più potenti, l’AGI è entrata nel mainstream e ha preso piede.

La grande cospirazione dell’AGI

Il termine “AGI” sarà anche stato reso popolare meno di 20 anni fa, ma il mito che lo circonda esiste fin dall’inizio dell’era dei computer: un cosmico fondo a microonde di sfrontatezza e marketing.

Alan Turing si chiese se le macchine potessero pensare solo cinque anni dopo la costruzione del primo computer elettronico, ENIAC, nel 1945. Ed ecco Turing poco dopo, in una trasmissione radiofonica del 1951: “Sembra probabile che, una volta avviato il metodo di pensiero della macchina, non ci vorrà molto tempo prima che superi le nostre deboli capacità. Non ci sarebbe alcun dubbio sulla morte delle macchine, che sarebbero in grado di conversare tra loro per affinare il loro ingegno. A un certo punto, quindi, dovremmo aspettarci che le macchine prendano il controllo”.

Poi, nel 1955, l’informatico John McCarthy e i suoi colleghi fecero richiesta di finanziamenti al governo degli Stati Uniti per creare quella che decisero di chiamare “intelligenza artificiale”, un nome azzeccato, dato che all’epoca i computer erano grandi come una stanza e stupidi come un termostato. Ciononostante, come scrisse McCarthy nella richiesta di finanziamento: “Si cercherà di trovare il modo di far sì che le macchine utilizzino il linguaggio, formino astrazioni e concetti, risolvano tipi di problemi attualmente riservati agli esseri umani e migliorino se stesse”.

È questo mito che sta alla base della cospirazione AGI. Una macchina più intelligente dell’uomo in grado di fare tutto non è una tecnologia. È un sogno, slegato dalla realtà. Una volta compreso questo, iniziano a emergere altri parallelismi con il pensiero cospirazionista.

È impossibile sfatare un’idea mutevole come l’AGI

Parlare di AGI a volte può sembrare come discutere con un utente entusiasta di Reddit su quali droghe (o particelle nel cielo) controllano la tua mente. Ogni punto ha un controargomento che cerca di minare il tuo senso di ciò che è vero. In definitiva, è uno scontro di visioni del mondo, non uno scambio di ragioni basate su prove. Anche l’AGI è così: è sfuggente.

Parte del problema è che, nonostante tutti i soldi e tutte le discussioni, nessuno sa come costruirla. Ma c’è di più: la maggior parte delle persone non è nemmeno d’accordo su cosa sia realmente l’AGI, il che aiuta a spiegare come si possa affermare che essa possa sia salvare il mondo che distruggerlo. Al centro della maggior parte delle definizioni si trova l’idea di una macchina in grado di eguagliare gli esseri umani in un’ampia gamma di compiti cognitivi. (E ricordate, la superintelligenza è il nuovo brillante aggiornamento dell’AGI: una macchina in grado di superarci). Ma anche questo è facile da smontare: di quali esseri umani stiamo parlando? Che tipo di compiti cognitivi? E quanto ampia è la gamma?

“Non esiste una definizione reale”, afferma Christopher Symons, capo scienziato di intelligenza artificiale presso la startup sanitaria Lirio e ex capo della divisione di informatica e matematica dell’Oak Ridge National Laboratory. “Se si parla di ‘intelligenza a livello umano’, potrebbe trattarsi di un numero infinito di cose: il livello di intelligenza di ognuno è leggermente diverso”.

E così, dice Symons, ci troviamo in questa strana corsa per costruire… cosa, esattamente? “Cosa si sta cercando di ottenere?”

Nel 2023, un team di ricercatori di Google DeepMind, tra cui Legg, ha provato a classificare le varie definizioni che le persone avevano proposto per l’AGI. Alcuni sostenevano che una macchina dovesse essere in grado di imparare; altri che dovesse essere in grado di guadagnare denaro; altri ancora che dovesse avere un corpo e muoversi nel mondo (e magari preparare il caffè).

Legg mi ha detto che quando aveva suggerito il termine a Goertzel per il titolo del suo libro, l’approssimazione era stata in qualche modo il punto centrale. “Non avevo una definizione particolarmente chiara. Non pensavo fosse davvero necessario”, ha detto all’epoca. “In realtà lo consideravo più un campo di studio che un artefatto”.

Quindi, immagino che lo riconosceremo quando lo vedremo? Il problema è che alcune persone pensano di averlo già visto.

Nel 2023, un team di ricercatori Microsoft ha pubblicato un articolo in cui descriveva le proprie esperienze con una versione preliminare del grande modello linguistico GPT-4 di OpenAI. Lo hanno chiamato “Sparks of Artificial General Intelligence” (Scintille di intelligenza artificiale generale) e ha polarizzato il settore.

È stato un momento in cui molti ricercatori sono rimasti sbalorditi e hanno cercato di venire a patti con ciò che stavano vedendo. “Funzionava meglio di quanto si aspettassero”, dice Goertzel. “Il concetto di AGI ha iniziato a sembrare davvero più plausibile”.

Eppure, nonostante i notevoli giochi di parole degli LLM, Goertzel non ritiene che essi contengano effettivamente scintille di AGI. “Mi sorprende un po’ che alcune persone con una profonda comprensione tecnica di come funzionano questi strumenti sotto il cofano continuino a pensare che potrebbero diventare AGI di livello umano”, afferma. “D’altra parte, non si può dimostrare che non sia vero”.

Ed ecco il punto: non si può dimostrare che non sia vero. “L’idea che l’AGI stia arrivando, che sia proprio dietro l’angolo e che sia inevitabile ha dato adito a molti allontanamenti dalla realtà”, afferma Vallor dell’Università di Edimburgo. “Ma in realtà non abbiamo alcuna prova a sostegno di questa teoria”.

Il pensiero cospiratorio torna a farsi sentire. Le previsioni su quando arriverà l’AGI vengono fatte con la precisione dei numerologi che contano alla rovescia fino alla fine dei giorni. Senza una vera posta in gioco, le scadenze vanno e vengono con un’alzata di spalle. Si trovano scuse e si modificano ancora una volta le tempistiche.

Lo abbiamo visto quando OpenAI ha rilasciato il tanto pubblicizzato GPT-5 quest’estate. Gli appassionati di IA sono rimasti delusi dal fatto che la nuova versione della tecnologia di punta dell’azienda non fosse il cambiamento radicale che si aspettavano. Ma invece di vederlo come una prova che l’AGI non era realizzabile, o almeno non con un LLM, i sostenitori hanno rinviato le loro previsioni su quanto presto sarebbe arrivata l’AGI. Stava arrivando, solo che, beh, la prossima volta.

Forse hanno ragione. O forse le persone sceglieranno qualsiasi prova a loro disposizione per difendere un’idea e trascureranno le prove che la contraddicono. Jeremy Cohen, che studia il pensiero cospirazionista nei circoli tecnologici alla McMaster University in Canada, definisce questo comportamento “raccolta imperfetta di prove”, un tratto distintivo del pensiero cospirazionista.

Cohen ha iniziato la sua carriera di ricercatore nel deserto dell’Arizona, studiando una comunità chiamata People Unlimited che credeva che i suoi membri fossero immortali. Questa convinzione era impermeabile alle prove contrarie. Quando i suoi membri morivano per cause naturali (compresi due dei suoi fondatori), si pensava che se lo fossero meritato. “Il consenso generale era che ogni morte fosse un suicidio”, dice Cohen. “Se sei immortale e ti viene il cancro e muori, beh, devi aver fatto qualcosa di sbagliato”.

Da allora Cohen si è concentrato sul transumanesimo (l’idea che la tecnologia possa aiutare gli esseri umani a superare i propri limiti naturali) e sull’AGI. “Vedo molti parallelismi. Ci sono forme di pensiero magico che ritengo facciano parte dell’immaginario popolare che circonda l’AGI”, afferma. “Si collega molto bene al tipo di immaginario religioso che si vede oggi nel pensiero cospirazionista”.

I credenti sono a conoscenza del segreto dell’AGI

Forse alcuni di voi pensano che io sia un idiota: non capite proprio niente lol. Ma è proprio questo il punto. Ci sono gli addetti ai lavori e gli estranei. Quando parlo con ricercatori o ingegneri che sono felici di inserire l’AGI nella conversazione come un dato di fatto, è come se sapessero qualcosa che io non so. Ma nessuno è mai stato in grado di dirmi di cosa si tratta.

La verità è là fuori, se sai dove cercare. Le teorie del complotto si occupano principalmente di rivelare una verità nascosta, mi dice Cohen: “È una parte davvero fondamentale del pensiero cospirazionista, ed è assolutamente qualcosa che si vede nel modo in cui le persone parlano dell’AGI”, dice.

L’anno scorso, Leopold Aschenbrenner, un ex dipendente di OpenAI di 23 anni diventato investitore, ha pubblicato un manifesto di 165 pagine molto discusso intitolato “Situational Awareness” (Consapevolezza situazionale). Non è necessario leggerlo per capirne il senso: o si vede la verità di ciò che sta per accadere o non la si vede. E non servono nemmeno fatti freddi e concreti, basta percepirlo. Chi non lo fa semplicemente non ha visto la luce.

Questa idea ha aleggiato anche ai margini della mia conversazione con Goertzel. Quando gli ho chiesto perché le persone sono scettiche nei confronti dell’AGI, ad esempio, ha risposto: “Prima di ogni grande conquista tecnologica, dal volo umano all’energia elettrica, molti esperti saggi ti avrebbero spiegato perché non sarebbe mai successo. Il fatto è che la maggior parte delle persone crede solo a ciò che vede davanti ai propri occhi”.

Questo fa sembrare l’AGI un articolo di fede. Ho sottoposto la questione a Krueger, che ritiene che l’arrivo dell’AGI sia forse a cinque anni di distanza. Lui ha risposto con tono beffardo: “Penso che sia completamente al contrario”. Per lui, l’articolo di fede è l’idea che non accadrà: sono gli scettici che continuano a negare l’ovvio. (Anche così, lui si copre le spalle: nessuno lo sa con certezza, dice, ma non c’è alcuna ragione evidente per cui l’AGI non arriverà).

Le verità nascoste attirano i cercatori di verità, determinati a rivelare ciò che hanno sempre potuto vedere. Con l’AGI, però, non basta scoprire qualcosa di nascosto. In questo caso, la rivelazione richiede un atto di creazione senza precedenti. Se credi che l’AGI sia realizzabile, allora credi che coloro che la realizzano siano le levatrici di macchine che eguaglieranno o supereranno l’intelligenza umana. “L’idea di dare alla luce dei dei meccanici è ovviamente molto lusinghiera per l’ego”, afferma Vallor. “È incredibilmente seducente pensare che tu stesso stia gettando le prime basi per quella trascendenza”.

È un’altra sovrapposizione con il pensiero cospirazionista. Parte del fascino è il desiderio di un senso di scopo in un mondo altrimenti caotico che può sembrare privo di significato: il desiderio di essere una persona importante.

Krueger, che vive a Berkeley, dice di conoscere persone che lavorano nell’ambito dell’IA e che vedono questa tecnologia come il nostro naturale successore. “La considerano come avere dei figli o qualcosa del genere”, afferma. “Nota a margine: di solito non hanno figli”.

L’AGI sarà il nostro unico vero salvatore (o porterà l’apocalisse)

Cohen vede dei parallelismi tra molte teorie cospirative moderne e il movimento New Age, che ha raggiunto il suo apice di influenza negli anni ’70 e ’80. I suoi aderenti credevano che l’umanità fosse sul punto di inaugurare un’era di benessere spirituale e di espansione della coscienza che avrebbe portato a un mondo più pacifico e prospero. In sintesi, l’idea era che, impegnandosi in una serie di pratiche pseudo-religiose, tra cui l’astrologia e l’attenta cura dei cristalli, gli esseri umani avrebbero superato i propri limiti ed entrato in una sorta di utopia hippie.

L’industria tecnologica odierna si basa sull’informatica, non sui cristalli, ma la sua percezione di ciò che è in gioco non è meno trascendente: “Sai, questa idea che ci sarà un cambiamento fondamentale, che ci sarà una svolta millenaria che ci porterà a un futuro tecno-utopico”, dice Cohen. “E l’idea che l’AGI alla fine permetterà all’umanità di superare i problemi che deve affrontare”.

Secondo molti, l’AGI arriverà tutta in una volta. I progressi incrementali nell’IA si accumuleranno fino a quando, un giorno, l’IA sarà abbastanza buona da iniziare a creare da sola un’IA migliore. A quel punto, con un FOOM, avanzerà così rapidamente che l’AGI arriverà in quella che viene spesso chiamata un’esplosione di intelligenza, portando a un punto di non ritorno noto come Singolarità, un termine buffo che è popolare da anni nei circoli dell’AGI. Cooptando un concetto dalla fisica, lo scrittore di fantascienza Vernor Vinge ha introdotto per la prima volta l’idea di una singolarità tecnologica negli anni ’80. Vinge immaginava un orizzonte degli eventi sul percorso del progresso tecnologico oltre il quale gli esseri umani sarebbero stati rapidamente superati dal miglioramento esponenziale delle macchine che avevano creato.

Chiamatelo Big Bang dell’IA, che, ancora una volta, ci offre un prima e un dopo, un momento trascendentale in cui l’umanità come la conosciamo cambia per sempre (nel bene o nel male). “La gente lo immagina come un evento”, dice Grace di AI Impacts.

Per Vallor, questo sistema di credenze è degno di nota per il modo in cui la fede nella tecnologia ha sostituito la fede nell’uomo. Nonostante il suo carattere esoterico, il pensiero New Age era almeno motivato dall’idea che le persone avessero ciò che serviva per cambiare il mondo da sole, se solo fossero riuscite ad attingervi. Con la ricerca dell’AGI, abbiamo abbandonato quella fiducia in noi stessi e abbiamo accettato l’idea che solo la tecnologia possa salvarci, afferma.

Questo è un pensiero convincente, persino confortante, per molte persone. “Siamo in un’epoca in cui altre vie per il miglioramento materiale della vita umana e delle nostre società sembrano essere state esaurite”, afferma Vallor.

Un tempo la tecnologia prometteva una strada verso un futuro migliore: il progresso era una scala che avremmo scalato verso la prosperità umana e sociale. “Abbiamo superato il picco”, afferma Vallor. “Penso che l’unica cosa che dia speranza a molte persone e un ritorno a quel tipo di ottimismo sul futuro sia l’AGI”.

Portando questa idea alle sue estreme conseguenze, l’AGI diventa una sorta di dio, in grado di offrire sollievo dalle sofferenze terrene, afferma Vallor.

Kelly Joyce, sociologa dell’Università della Carolina del Nord che studia come le credenze culturali, politiche ed economiche influenzano il modo in cui pensiamo e utilizziamo la tecnologia, vede tutte queste previsioni azzardate sull’AGI come qualcosa di più banale: parte di un modello a lungo termine di promesse eccessive da parte dell’industria tecnologica. “Ciò che mi interessa è che ogni volta ci lasciamo coinvolgere”, afferma. “C’è una profonda convinzione che la tecnologia sia migliore degli esseri umani”.

Joyce pensa che sia per questo che, quando inizia l’hype, le persone sono predisposte a crederci. “È una religione”, afferma. “Crediamo nella tecnologia. La tecnologia è Dio. È davvero difficile opporsi. Le persone non vogliono sentirne parlare”.

Come l’AGI ha dirottato un settore

La fantasia di computer in grado di fare quasi tutto ciò che può fare una persona è seducente. Ma come molte teorie cospirative diffuse, ha conseguenze molto reali. Ha distorto il modo in cui pensiamo alla posta in gioco dietro l’attuale boom tecnologico (e al potenziale crollo). Potrebbe persino aver fatto deragliare l’industria, sottraendo risorse ad applicazioni più immediate e pratiche della tecnologia. Più di ogni altra cosa, ci dà un permesso gratuito per essere pigri. Ci induce a pensare che potremmo essere in grado di evitare il duro lavoro necessario per risolvere problemi irrisolvibili e di portata mondiale, problemi che richiederanno cooperazione internazionale, compromessi e aiuti costosi. Perché preoccuparsene quando presto avremo macchine che risolveranno tutto per noi?

Consideriamo le risorse investite in questo grande progetto. Proprio il mese scorso, OpenAI e Nvidia hanno annunciato una partnership da 100 miliardi di dollari che vedrà il gigante dei chip fornire almeno 10 gigawatt per soddisfare l’insaziabile domanda di ChatGPT. Si tratta di una cifra superiore a quella delle centrali nucleari. Un fulmine potrebbe rilasciare una quantità di energia simile. Il flusso canalizzatore all’interno della macchina del tempo DeLorean del dottor Emmett Brown richiedeva solo 1,2 gigawatt per rimandare Marty nel futuro. E poi, solo due settimane dopo, OpenAI ha annunciato una seconda partnership con il produttore di chip AMD per altri sei gigawatt di potenza.

Promuovendo l’accordo con Nvidia sulla CNBC, Altman, con espressione seria, ha affermato che senza questo tipo di ampliamento dei data center, le persone dovrebbero scegliere tra una cura per il cancro e l’istruzione gratuita. “Nessuno vuole fare questa scelta”, ha detto. (Solo poche settimane dopo, ha annunciato che le chat erotiche sarebbero arrivate su ChatGPT).

A questi costi si aggiunge la perdita di investimenti in tecnologie più immediate che potrebbero cambiare la vita oggi, domani e dopodomani. “Per me è un’enorme opportunità persa”, afferma Symons di Lirio, “investire tutte queste risorse nella risoluzione di qualcosa di nebuloso quando sappiamo già che ci sono problemi reali che potremmo risolvere”.

Ma non è così che devono operare aziende come OpenAI. “Con tutte le persone che investono così tanto denaro in queste aziende, non hanno bisogno di farlo”, afferma Symons. “Se hai centinaia di miliardi di dollari, non devi concentrarti su un progetto pratico e risolvibile”.

Nonostante la sua ferma convinzione che l’AGI sia ormai alle porte, Krueger ritiene anche che l’impegno esclusivo del settore in tal senso comporti l’ignoranza di potenziali soluzioni a problemi reali, come una migliore assistenza sanitaria. “Questa storia dell’AGI è una sciocchezza, una distrazione, una montatura”, mi dice.

E ci sono conseguenze per il modo in cui i governi sostengono e regolamentano la tecnologia (o non lo fanno). Tina Law, che studia politica tecnologica all’Università della California-Davis, teme che i responsabili politici siano sottoposti a pressioni sul fatto che un giorno l’IA ci ucciderà tutti, invece di affrontare le preoccupazioni reali e i su come l’IA potrebbe influenzare la vita delle persone in modo immediato e concreto oggi. La disuguaglianza è stata messa da parte dal rischio esistenziale.

“L’hype è una strategia redditizia per le aziende tecnologiche”, afferma Law. Gran parte di questo hype è alimentato dall’idea che ciò che sta accadendo sia inevitabile: se non lo costruiamo noi, lo farà qualcun altro. “Quando qualcosa viene presentato come inevitabile”, dice Law, “le persone dubitano non solo se debbano opporsi, ma anche se abbiano la capacità di farlo”. Tutti rimangono intrappolati.

Il campo di distorsione dell’AGI non si limita alla politica tecnologica, afferma Milton Mueller del Georgia Institute of Technology, che si occupa di politica e regolamentazione tecnologica. La corsa all’AGI viene paragonata alla corsa alla bomba atomica, afferma. “Quindi chiunque la otterrà per primo avrà il potere assoluto su tutti gli altri. È un’idea folle e pericolosa che distorcerà davvero il nostro approccio alla politica estera”.

C’è un incentivo commerciale per le aziende (e i governi) a promuovere il mito dell’AGI, afferma Mueller, perché possono poi affermare che saranno i primi a raggiungerlo. Ma poiché stanno correndo una gara in cui nessuno ha concordato il traguardo, il mito può essere alimentato finché è utile. O finché gli investitori sono disposti a crederci.

Non è difficile capire come andrà a finire. Non si tratta di utopia o inferno, ma di OpenAI e delle sue simili che guadagneranno molti più soldi.

La grande cospirazione dell’AGI, conclusa

E forse questo ci riporta all’intera questione della cospirazione e a un colpo di scena finale in questa storia. Finora abbiamo ignorato una caratteristica popolare del pensiero cospirazionista: che esiste un gruppo di figure potenti che tirano le fila dietro le quinte e che, cercando la verità, i credenti possono smascherare questa élite segreta.

Certo, le persone che credono nell’AGI non accusano pubblicamente nessuna forza simile agli Illuminati o al WEF di impedire il futuro dell’AGI o di nasconderne i segreti.

Ma se in realtà ci fossero dei burattinai nell’ombra, e fossero proprio loro ad aver spinto con più forza la cospirazione sull’AGI? I re della Silicon Valley stanno investendo tutto ciò che possono nella costruzione dell’AGI a scopo di lucro. Il mito dell’AGI serve i loro interessi più di quelli di chiunque altro.

Come ci ha detto recentemente un alto dirigente di un’azienda di IA, l’AGI deve sempre essere a sei mesi o un anno di distanza, perché se fosse più lontana di così, non sarebbe possibile reclutare persone da Jane Street, e se fosse più vicina, allora che senso avrebbe?

Come afferma Vallor: “Se OpenAI dicesse che sta costruendo una macchina che renderà le aziende ancora più potenti di quanto non lo siano oggi, non otterrebbe il sostegno pubblico di cui ha bisogno”.

Ricorda: se crei un dio, diventi tu stesso come lui. Krueger afferma che nella Silicon Valley esiste una linea di pensiero secondo cui la creazione dell’IA è un modo per acquisire un enorme potere. (È una delle premesse del libro “Situational Awareness” di Aschenbrenner, ad esempio). “Sapete, avremo questo potere divino e dovremo capire cosa farne “, afferma Krueger. “Molti pensano che se ci arriveranno per primi, potranno praticamente conquistare il mondo”.

“Stanno investendo molte energie nel promuovere la loro visione di un futuro con l’AGI e stanno ottenendo un discreto successo perché hanno molto potere”, aggiunge.

Goertzel, per esempio, quasi si rammarica del successo ottenuto da quella che potrebbe essere definita una cricca. In realtà, sta iniziando a rimpiangere la vita ai margini. “Nella mia generazione, bisognava avere una grande visione per voler lavorare sull’AGI, e bisognava essere molto testardi”, afferma. “Ora è quasi come quello che ti dice tua nonna di fare per trovare un lavoro invece di laurearti in economia”.

“È disorientante che questa cosa sia così ampiamente accettata”, dice. “Mi fa quasi venire voglia di andare a lavorare su qualcos’altro che non fanno in tanti”. Sta scherzando, almeno in parte (credo): “Ovviamente, dare gli ultimi ritocchi all’AGI è più importante che soddisfare la mia preferenza di stare fuori dai giochi”.

Ma non mi è chiaro su cosa stiano dando gli ultimi ritocchi. Cosa significa per la tecnologia in generale se ci lasciamo conquistare così facilmente dalle favole? Per molti versi, penso che l’idea stessa di AGI sia costruita su una visione distorta di ciò che dovremmo aspettarci dalla tecnologia e persino di cosa sia l’intelligenza in primo luogo. Ridotta alla sua essenza, l’argomentazione a favore dell’AGI si basa sulla premessa che una tecnologia, l’IA, è diventata molto buona, molto veloce e continuerà a migliorare. Ma mettendo da parte le obiezioni tecniche – e se non continuasse a migliorare? – rimane l’affermazione che l’intelligenza è una merce di cui si può ottenere di più se si dispone dei dati, della potenza di calcolo o della rete neurale giusti. E non è così.

L’intelligenza non è una quantità che si può semplicemente aumentare all’infinito. Le persone intelligenti possono essere brillanti in un settore e non in altri. Alcuni vincitori del Premio Nobel sono davvero negati nel suonare il pianoforte o nel prendersi cura dei propri figli. Alcune persone molto intelligenti insistono nel dire che l’AGI arriverà il prossimo anno.

È difficile non chiedersi cosa ci conquisterà la prossima volta.

Prima di concludere la nostra conversazione, Goertzel mi ha parlato di un evento a cui aveva appena partecipato a San Francisco sull’intelligenza artificiale, la coscienza e la parapsicologia: “ESP, precognizione e quant’altro”.

“È lì che si trovava l’AGI 20 anni fa”, ha detto. “Tutti pensano che sia una follia”.