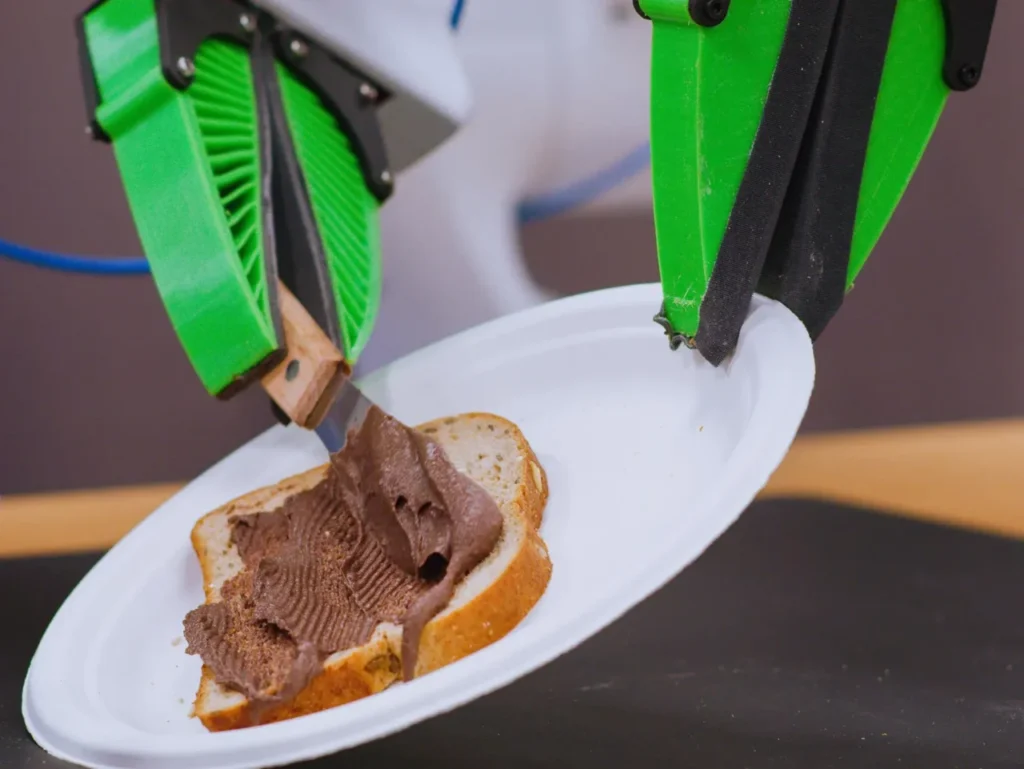

I ricercatori stanno utilizzando l’intelligenza artificiale generativa e altre tecniche per insegnare ai robot nuove abilità, tra cui i compiti che potrebbero svolgere nelle case.

Silenzioso. Rigido. Goffo.

Henry e Jane Evans sono abituati ad avere ospiti scomodi. Per oltre un decennio, la coppia, che vive a Los Altos Hills, in California, ha ospitato una serie di robot nella propria casa.

Nel 2002, all’età di 40 anni, Henry è stato colpito da un grave ictus che lo ha reso tetraplegico e incapace di parlare. Da allora ha imparato a comunicare muovendo gli occhi su una lavagna per le lettere, ma si affida molto agli assistenti e alla moglie Jane.

Henry ha avuto un assaggio di una vita diversa quando ha visto Charlie Kemp alla CNN nel 2010. Kemp, professore di robotica alla Georgia Tech, era in TV per parlare di PR2, un robot sviluppato dall’azienda Willow Garage. PR2 era un’enorme macchina a due braccia su ruote che sembrava un rozzo maggiordomo di metallo. Kemp stava dimostrando il funzionamento del robot e parlava della sua ricerca su come i robot per l’assistenza sanitaria potrebbero aiutare le persone. Ha mostrato come il robot PR2 potesse consegnare alcune medicine al conduttore televisivo.

“All’improvviso, Henry si è girato verso di me e mi ha detto: “Perché quel robot non può essere un’estensione del mio corpo?”. E io ho risposto: “Perché no?””. Racconta Jane.

C’era un motivo valido per non farlo. Mentre gli ingegneri hanno fatto grandi progressi nel far funzionare i robot in ambienti strettamente controllati come laboratori e fabbriche, la casa si è dimostrata difficile da progettare. Nel mondo reale e disordinato, i mobili e le planimetrie variano in modo selvaggio, i bambini e gli animali domestici possono intralciare il robot e i vestiti da piegare sono di forme, colori e dimensioni diverse. La gestione di ambienti imprevedibili e di condizioni così varie è stata al di là delle capacità anche dei prototipi di robot più avanzati.

Questo sembra finalmente cambiare, in gran parte grazie all’intelligenza artificiale. Per decenni, i robotisti si sono concentrati più o meno sul controllo dei “corpi” dei robot – le loro braccia, gambe, leve, ruote e simili – attraverso un software mirato. Ma una nuova generazione di scienziati e inventori ritiene che l’ingrediente finora mancante dell’intelligenza artificiale possa dare ai robot la capacità di apprendere nuove abilità e adattarsi a nuovi ambienti più velocemente che mai. Questo nuovo approccio, forse, può finalmente portare i robot fuori dalle fabbriche e nelle nostre case.

Tuttavia, i progressi non avverranno da un giorno all’altro, come gli Evans sanno fin troppo bene avendo utilizzato per molti anni diversi prototipi di robot.

PR2 è stato il primo robot che hanno introdotto e che ha aperto a Henry nuove possibilità. Il robot teneva in mano un rasoio per la barba e Henry muoveva il viso contro di esso, permettendogli di radersi e grattarsi un prurito da solo per la prima volta in un decennio. Ma con un peso di circa 200 chilogrammi e 400.000 dollari, il robot era difficile da tenere in giro. “Poteva facilmente abbattere una parete della casa”, racconta Jane. “Non ero una grande fan”.

Più recentemente, gli Evans hanno testato un robot più piccolo, chiamato Stretch, che Kemp ha sviluppato attraverso la sua startup Hello Robot. La prima iterazione è stata lanciata durante la pandemia con un prezzo molto più ragionevole di circa 18.000 dollari.

Stretch pesa circa 50 libbre. Ha una piccola base mobile, un bastone con una telecamera che penzola da esso e un braccio regolabile dotato di una pinza con ventose alle estremità. Può essere controllato con un controller per console. Henry controlla Stretch utilizzando un computer portatile, con uno strumento che segue i movimenti della sua testa per muovere un cursore. È in grado di muovere il pollice e l’indice a sufficienza per fare clic sul mouse di un computer. L’estate scorsa Stretch è stato con la coppia per più di un mese e Henry dice che gli ha dato un nuovo livello di autonomia. “Era pratico e potevo immaginare di usarlo tutti i giorni”, dice.

PETER ADAMS

Utilizzando il suo computer portatile, ha potuto far sì che il robot gli spazzolasse i capelli e gli tenesse in mano degli spiedini di frutta da mangiare. Questo sistema ha anche aperto il rapporto di Henry con la nipote Teddie. Prima i due interagivano a malapena. “Non lo abbracciava affatto per salutarlo. Niente del genere”, racconta Jane. Ma “Papa Wheelie” e Teddie hanno usato lo Stretch per giocare, facendo gare di staffetta, bowling e pesca magnetica.

Stretch non ha molto di intelligente: viene fornito con alcuni software preinstallati, come l’interfaccia web che Henry usa per controllarlo, e altre funzionalità come la navigazione abilitata dall’intelligenza artificiale. Il vantaggio principale di Stretch è che le persone possono inserire i propri modelli di intelligenza artificiale e usarli per fare esperimenti. Ma offre un’idea di come potrebbe essere un mondo con robot domestici utili. I robot che possono fare molte delle cose che gli esseri umani fanno in casa, come piegare il bucato, cucinare i pasti e pulire, sono stati il sogno della ricerca sulla robotica fin dall’inizio del settore, negli anni Cinquanta. Per molto tempo, è stato proprio così: “La robotica è piena di sognatori”, dice Kemp.

Ken Goldberg, professore di robotica presso l’Università della California, Berkeley, sostiene che il settore si trova a un punto di svolta. Secondo lui, i precedenti tentativi di costruire un robot domestico utile hanno fallito clamorosamente nel soddisfare le aspettative create dalla cultura popolare, come la cameriera robotica di The Jetsons. Ora le cose sono molto diverse. Grazie all’hardware a basso costo come Stretch, agli sforzi per raccogliere e condividere i dati e ai progressi dell’intelligenza artificiale generativa, i robot stanno diventando più competenti e utili che mai. “Siamo a un punto in cui siamo molto vicini a ottenere capacità che saranno davvero utili”, afferma Goldberg.

Piegare il bucato, cucinare i gamberetti, pulire le superfici, scaricare i cestini della spesa: oggi i robot dotati di intelligenza artificiale stanno imparando a svolgere compiti che per i loro predecessori sarebbero stati estremamente difficili.

Pezzi mancanti

C’è un’osservazione ben nota tra i robotisti: ciò che è difficile per gli esseri umani è facile per le macchine, e ciò che è facile per gli esseri umani è difficile per le macchine. Chiamato paradosso di Moravec, è stato formulato per la prima volta negli anni ’80 da Hans Moravec, robotista presso il Robotics Institute della Carnegie Mellon University. Un robot può giocare a scacchi o tenere fermo un oggetto per ore e ore senza problemi. Legare un laccio, prendere una palla o conversare è un’altra cosa.

Le ragioni sono tre, secondo Goldberg. In primo luogo, i robot non hanno un controllo e una coordinazione precisi. In secondo luogo, la loro comprensione del mondo circostante è limitata perché si affidano a telecamere e sensori per percepirlo. In terzo luogo, mancano di un senso innato della fisica pratica.

“Se prendete un martello, probabilmente vi cadrà dalla pinza, a meno che non lo afferriate vicino alla parte pesante. Ma questo non si può sapere se lo si guarda e basta, a meno che non si conosca il funzionamento dei martelli”, dice Goldberg.

Oltre a queste considerazioni di base, ci sono molti altri aspetti tecnici che devono essere perfetti, dai motori alle telecamere alle connessioni Wi-Fi, e l’hardware può avere costi proibitivi. Da tempo siamo in grado di fare cose abbastanza complesse dal punto di vista meccanico. In un video del 1957, due grandi braccia robotiche sono sufficientemente abili da pizzicare una sigaretta, metterla in bocca a una donna che sta scrivendo a macchina e riapplicarle il rossetto. Ma l’intelligenza e la consapevolezza spaziale di quel robot derivavano dalla persona che lo manovrava.

“Il pezzo mancante è: come facciamo a far sì che il software faccia [queste cose] automaticamente?”, afferma Deepak Pathak, professore assistente di informatica alla Carnegie Mellon.

I ricercatori che si occupano di addestramento dei robot hanno tradizionalmente affrontato questo problema pianificando tutto ciò che il robot fa nei minimi dettagli. Il gigante della robotica Boston Dynamics ha utilizzato questo approccio quando ha sviluppato il suo robot umanoide Atlas, in grado di fare booging e parkouring. Le telecamere e la visione computerizzata vengono utilizzate per identificare gli oggetti e le scene. I ricercatori usano poi questi dati per creare modelli che possono essere utilizzati per prevedere con estrema precisione cosa accadrà se un robot si muove in un certo modo. Utilizzando questi modelli, i robotisti pianificano i movimenti delle loro macchine scrivendo un elenco molto specifico di azioni da compiere. Gli ingegneri testano poi questi movimenti in laboratorio molte volte e li mettono a punto alla perfezione.

Questo approccio ha i suoi limiti. I robot addestrati in questo modo sono strettamente coreografati per lavorare in un ambiente specifico. Se li si porta fuori dal laboratorio in un luogo sconosciuto, è probabile che si rovescino.

Rispetto ad altri campi, come la computer vision, la robotica è rimasta nell’era oscura, dice Pathak. Ma questo potrebbe non essere il caso ancora per molto, perché il campo sta subendo una grande scossa. Grazie al boom dell’intelligenza artificiale, spiega Pathak, l’attenzione si sta spostando dalle prodezze di destrezza fisica alla costruzione di “cervelli robotici generici” sotto forma di reti neurali. Così come il cervello umano è adattabile e può controllare diversi aspetti del corpo umano, queste reti possono essere adattate per funzionare con diversi robot e diversi scenari. I primi segnali di questo lavoro mostrano risultati promettenti.

I robot incontrano l’intelligenza artificiale

Per molto tempo, la ricerca sulla robotica è stata un campo spietato, afflitto da progressi lenti. Al Robotics Institute della Carnegie Mellon, dove Pathak lavora, dice che “un tempo si diceva che se toccavi un robot, aggiungevi un anno al tuo dottorato”. Ora, dice, gli studenti vengono esposti a molti robot e vedono i risultati nel giro di poche settimane.

Ciò che distingue questa nuova generazione di robot è il loro software. Al posto della pianificazione e dell’addestramento tradizionali, i robot hanno iniziato a usare l’apprendimento profondo e le reti neurali per creare sistemi che imparano dall’ambiente circostante e regolano il loro comportamento di conseguenza. Allo stesso tempo, un hardware nuovo e più economico, come i componenti di serie e i robot come Stretch, rende più accessibile questo tipo di sperimentazione.

In generale, i ricercatori utilizzano l’intelligenza artificiale per addestrare i robot in due modi molto diffusi. Pathak ha utilizzato l’apprendimento per rinforzo, una tecnica di intelligenza artificiale che consente ai sistemi di migliorare attraverso tentativi ed errori, per far sì che i robot adattino i loro movimenti in nuovi ambienti. È una tecnica che anche Boston Dynamics ha iniziato a utilizzare per i suoi “cani” robot chiamati Spot.

Il team di Deepak Pathak della Carnegie Mellon ha utilizzato una tecnica di intelligenza artificiale chiamata apprendimento per rinforzo per creare un cane robotico in grado di fare parkour estremo con una minima pre-programmazione.

Nel 2022, il team di Pathak ha utilizzato questo metodo per creare “cani” robotici a quattro zampe in grado di arrampicarsi su per i gradini e navigare su terreni difficili. I robot sono stati prima addestrati a muoversi in modo generico in un simulatore. Poi sono stati lasciati liberi nel mondo reale, con un’unica telecamera incorporata e un software di visione computerizzata a guidarli. Altri robot simili si affidano a mappe interne del mondo strettamente prescritte e non possono navigare oltre.

Pathak afferma che l’approccio del team è stato ispirato dalla navigazione umana. Gli esseri umani ricevono informazioni sul mondo circostante dagli occhi e questo li aiuta a mettere istintivamente un piede davanti all’altro per muoversi in modo appropriato. In genere, quando camminano, gli esseri umani non guardano il terreno sotto i loro piedi, ma qualche passo più avanti, verso il punto in cui vogliono andare. Il team di Pathak ha addestrato i suoi robot ad adottare un approccio simile alla camminata: ognuno di essi ha usato la telecamera per guardare avanti. Il robot è stato quindi in grado di memorizzare ciò che aveva davanti per un tempo sufficiente a guidare il posizionamento delle gambe. I robot imparavano a conoscere il mondo in tempo reale, senza mappe interne, e regolavano il loro comportamento di conseguenza. All’epoca, gli esperti dissero al MIT Technology Review che la tecnica rappresentava una “svolta nell’apprendimento e nell’autonomia dei robot” e che avrebbe potuto consentire ai ricercatori di costruire robot con le zampe in grado di essere impiegati in natura.

Da allora i cani robot di Pathak sono saliti di livello. L’ultimo algoritmo del team permette a un robot quadrupede di fare parkour estremo. Il robot è stato addestrato a muoversi in modo generico in una simulazione. Ma utilizzando l’apprendimento per rinforzo, è stato in grado di apprendere nuove abilità in movimento, come saltare lunghe distanze, camminare sulle zampe anteriori e arrampicarsi su scatole alte il doppio della sua altezza. Questi comportamenti non sono stati programmati dai ricercatori. Al contrario, il robot ha imparato per tentativi ed errori e grazie agli input visivi della sua telecamera frontale. “Tre anni fa non credevo che fosse possibile”, afferma Pathak.

Nell’altra tecnica popolare, chiamata apprendimento per imitazione, i modelli imparano a eseguire compiti, ad esempio imitando le azioni di un umano che teleopera un robot o usando un set VR per raccogliere dati su un robot. Si tratta di una tecnica che è passata di moda nel corso dei decenni, ma che di recente è diventata più popolare con i robot che svolgono attività di manipolazione, spiega Russ Tedrake, vicepresidente della ricerca robotica presso il Toyota Research Institute e professore del MIT.

Abbinando questa tecnica all’IA generativa, i ricercatori del Toyota Research Institute, della Columbia University e del MIT sono riusciti a insegnare rapidamente ai robot a svolgere molti nuovi compiti. Ritengono di aver trovato un modo per estendere la tecnologia che spinge l’IA generativa dal regno del testo, delle immagini e dei video al dominio dei movimenti dei robot.

L’idea è quella di iniziare con un umano, che controlla manualmente il robot per dimostrare comportamenti come sbattere le uova o raccogliere i piatti. Utilizzando una tecnica chiamata politica di diffusione, il robot è poi in grado di utilizzare i dati che gli vengono forniti per apprendere le abilità. I ricercatori hanno insegnato ai robot più di 200 abilità, come sbucciare le verdure e versare i liquidi, e dicono che stanno lavorando per insegnarne 1.000 entro la fine dell’anno.

Anche molti altri hanno sfruttato l’IA generativa. Covariant, una startup di robotica nata dall’unità di ricerca sulla robotica di OpenAI, ora chiusa, ha costruito un modello multimodale chiamato RFM-1. Può accettare richieste sotto forma di testo, immagini, video, istruzioni robotiche o misurazioni. L’intelligenza artificiale generativa consente al robot di comprendere le istruzioni e di generare immagini o video relativi a tali compiti.

Il team del Toyota Research Institute spera che questo possa portare un giorno a “grandi modelli di comportamento”, analoghi a grandi modelli di linguaggio, dice Tedrake. “Molte persone pensano che la clonazione del comportamento ci porterà a un momento per la robotica simile a quello avuto per ChatGPT”, afferma Tedrake.

In una dimostrazione analoga, all’inizio di quest’anno un team di Stanford è riuscito a utilizzare un robot di serie relativamente economico, del costo di 32.000 dollari, per svolgere compiti di manipolazione complessi come cucinare gamberi e pulire le macchie. Il robot ha appreso rapidamente queste nuove abilità grazie all’intelligenza artificiale.

Chiamato Mobile ALOHA (un acronimo non chiaro per “a low-cost open-source hardware teleoperation system”), il robot ha imparato a cucinare i gamberi con l’aiuto di sole 20 dimostrazioni umane e dati provenienti da altri compiti, come strappare un tovagliolo di carta o un pezzo di nastro adesivo. I ricercatori di Stanford hanno scoperto che l’intelligenza artificiale può aiutare i robot ad acquisire competenze trasferibili: l’addestramento su un compito può migliorare le prestazioni per altri.

Mentre l’attuale generazione di IA generativa lavora con le immagini e il linguaggio, i ricercatori del Toyota Research Institute, della Columbia University e del MIT ritengono che l’approccio possa estendersi al dominio del movimento dei robot.

Tutto questo pone le basi per robot che possano essere utili nelle case. Le esigenze umane cambiano nel tempo e insegnare ai robot a svolgere in modo affidabile un’ampia gamma di compiti è importante, perché li aiuterà ad adattarsi a noi. Questo aspetto è cruciale anche per la commercializzazione: i robot domestici di prima generazione avranno un prezzo elevato e devono possedere abilità sufficientemente utili da indurre i consumatori a investire in loro.

Per molto tempo, gran parte della comunità robotica è stata molto scettica nei confronti di questo tipo di approcci, afferma Chelsea Finn, professore assistente di informatica e ingegneria elettrica all’Università di Stanford e consulente del progetto Mobile ALOHA. Finn racconta che quasi un decennio fa, gli approcci basati sull’apprendimento erano rari alle conferenze di robotica e denigrati nella comunità robotica. “Il boom [dell’elaborazione del linguaggio naturale] ha convinto un numero maggiore di persone della comunità che questo approccio è davvero molto potente”, afferma Finn.

C’è però una fregatura. Per imitare nuovi comportamenti, i modelli di intelligenza artificiale hanno bisogno di molti dati.

Di più è di più

A differenza dei chatbot, che possono essere addestrati utilizzando miliardi di dati raccolti da Internet, i robot hanno bisogno di dati creati appositamente per i robot. Hanno bisogno di dimostrazioni fisiche di come si aprono le lavatrici e i frigoriferi, si raccolgono i piatti o si piega il bucato, spiega Lerrel Pinto, assistente alla cattedra di informatica della New York University. Al momento questi dati sono molto scarsi e richiedono molto tempo per essere raccolti dagli esseri umani.

Alcuni ricercatori stanno cercando di utilizzare video esistenti di esseri umani che fanno cose per addestrare i robot, sperando che le macchine siano in grado di copiare le azioni senza bisogno di dimostrazioni fisiche.

Il laboratorio di Pinto ha anche sviluppato un approccio di raccolta dati pulito ed economico che collega i movimenti robotici alle azioni desiderate. I ricercatori hanno preso un bastone raccoglitore, simile a quelli usati per raccogliere la spazzatura, e lo hanno collegato a un iPhone. I volontari umani possono usare questo sistema per filmarsi mentre svolgono le faccende domestiche, imitando la vista del robot all’estremità del suo braccio robotico. Utilizzando questa controfigura del braccio robotico di Stretch e un sistema open source chiamato DOBB-E, il team di Pinto è riuscito a far apprendere a un robot Stretch compiti come versare da una tazza e aprire le tende della doccia con soli 20 minuti di dati iPhone.

Ma per compiti più complessi, i robot avrebbero bisogno di un numero ancora maggiore di dati e di dimostrazioni.

La scala richiesta sarebbe difficile da raggiungere con DOBB-E, dice Pinto, perché bisognerebbe convincere ogni essere umano sulla Terra ad acquistare il sistema reacher-grabber, raccogliere dati e caricarli su Internet.

Una nuova iniziativa avviata da Google DeepMind, chiamata Open X-Embodiment Collaboration, mira a cambiare le cose. L’anno scorso, l’azienda ha collaborato con 34 laboratori di ricerca e circa 150 ricercatori per raccogliere dati da 22 diversi robot, tra cui Stretch di Hello Robot. Il set di dati risultante, pubblicato nell’ottobre 2023, consiste in robot che dimostrano 527 abilità, come raccogliere, spingere e spostare.

Sergey Levine, un informatico dell’UC Berkeley che ha partecipato al progetto, afferma che l’obiettivo era quello di creare una “Internet dei robot” raccogliendo dati dai laboratori di tutto il mondo. In questo modo i ricercatori avrebbero avuto accesso a set di dati più grandi, più scalabili e più diversificati. La rivoluzione del Deep Learning che ha portato all’IA generativa di oggi è iniziata nel 2012 con la nascita di ImageNet, un vasto insieme di dati online di immagini. La Open X-Embodiment Collaboration è un tentativo della comunità robotica di fare qualcosa di simile per i dati dei robot.

I primi segnali mostrano che un maggior numero di dati sta portando a robot più intelligenti. I ricercatori hanno costruito due versioni di un modello per i robot, chiamato RT-X, che può essere eseguito localmente sui computer dei singoli laboratori o consultato via web. Il modello più grande, accessibile via web, è stato preaddestrato con i dati di Internet per sviluppare un “senso comune visivo”, o una comprensione di base del mondo, a partire dai modelli di linguaggio e di immagini.

Quando i ricercatori hanno utilizzato il modello RT-X su molti robot diversi, hanno scoperto che i robot erano in grado di apprendere le abilità con il 50% di successo in più rispetto ai sistemi che ogni singolo laboratorio stava sviluppando.

“Credo che nessuno se lo aspettasse”, afferma Vincent Vanhoucke, responsabile della robotica di Google DeepMind. “Improvvisamente c’è la possibilità di sfruttare tutte queste altre fonti di dati per ottenere comportamenti molto intelligenti nella robotica”. Molti robotisti pensano che i modelli di visione-linguaggio di grandi dimensioni, che sono in grado di analizzare i dati delle immagini e del linguaggio, potrebbero offrire ai robot importanti indicazioni su come funziona il mondo circostante, dice Vanhoucke. Offrono indizi semantici sul mondo e potrebbero aiutare i robot a ragionare, dedurre cose e imparare interpretando le immagini. Per verificarlo, i ricercatori hanno preso un robot addestrato sul modello più grande e gli hanno chiesto di indicare una foto di Taylor Swift. I ricercatori non avevano mostrato al robot immagini della Swift, ma il robot è stato comunque in grado di identificare la pop star perché aveva una comprensione su scala web di chi fosse anche senza foto di lei nel suo set di dati, dice Vanhoucke.

Vanhoucke afferma che Google DeepMind sta utilizzando sempre più spesso tecniche simili a quelle che userebbe per la traduzione automatica per tradurre dall’inglese alla robotica. La scorsa estate, Google ha introdotto un modello di visione-linguaggio-azione chiamato RT-2. Questo modello ricava la sua comprensione generale del mondo da testi e immagini online su cui è stato addestrato, oltre che dalle sue stesse interazioni nel mondo reale. Traduce questi dati in azioni robotiche. Ogni robot ha un modo leggermente diverso di tradurre l’inglese in azioni, aggiunge.

“Abbiamo sempre più l’impressione che un robot sia essenzialmente un chatbot che parla in robotese”, afferma Vanhoucke.

Piccoli passi

Nonostante il rapido ritmo di sviluppo, i robot devono ancora affrontare molte sfide prima di poter essere immessi nel mondo reale. Sono ancora troppo goffi perché i consumatori normali possano giustificare una spesa di decine di migliaia di dollari. Inoltre, ai robot manca ancora quel tipo di buon senso che consentirebbe loro di svolgere più attività. Inoltre, secondo Goldberg, devono passare dal prendere le cose e metterle da qualche parte al metterle insieme, ad esempio rimettere un mazzo di carte o un gioco da tavolo nella sua scatola e poi nell’armadio dei giochi.

Ma a giudicare dai primi risultati dell’integrazione dell’intelligenza artificiale nei robot, i robotisti non stanno perdendo tempo, dice Pinto.

“Mi sento abbastanza sicuro che vedremo una parvenza di robot domestico di uso generale. Sarà accessibile al grande pubblico? Non credo”, afferma. “Ma in termini di intelligenza grezza, stiamo già vedendo dei segnali in questo momento”.

La costruzione della prossima generazione di robot potrebbe non limitarsi ad assistere gli esseri umani nelle loro faccende quotidiane o ad aiutare persone come Henry Evans a vivere una vita più indipendente. Per ricercatori come Pinto, c’è un obiettivo ancora più grande in vista.

La robotica domestica offre uno dei migliori parametri di riferimento per l’intelligenza delle macchine a livello umano. Il fatto che un essere umano possa operare in modo intelligente nell’ambiente domestico, aggiunge, significa che sappiamo che questo è un livello di intelligenza che può essere raggiunto. “È qualcosa che possiamo potenzialmente risolvere. Solo che non sappiamo come risolverlo”, afferma.

VY NGUYEN

Per Henry e Jane Evans, una grande vittoria sarebbe ottenere un robot che funzioni in modo affidabile. Il robot Stretch che gli Evans hanno sperimentato è ancora troppo difettoso per essere usato senza la presenza di ricercatori per risolvere i problemi, e la loro casa non dispone sempre della connettività Wi-Fi affidabile di cui Henry ha bisogno per comunicare con Stretch usando un computer portatile.

Tuttavia, Henry afferma che uno dei maggiori vantaggi del suo esperimento con i robot è stata l’indipendenza: “Tutto ciò che faccio è stare a letto, e ora posso fare cose per me stesso che comportano la manipolazione del mio ambiente fisico”.

Grazie a Stretch, per la prima volta in due decenni, Henry fu in grado di reggere le sue carte da gioco durante una partita.

“Ho preso a calci in culo tutti più volte”, dice.

“Ok, non parliamo troppo in grande”, dice Jane e ride.