La nuova tecnologia di Synthesia è impressionante, ma solleva grandi interrogativi su un mondo in cui sempre più spesso non riusciamo a capire cosa sia reale.

Sono stressata e in ritardo, perché devo decidere cosa indossare per il resto dell’eternità.

Sembra che io stia per morire, ma è il contrario. In un certo senso, sto per vivere per sempre, grazie alla startup di video AI Synthesia. Negli ultimi anni, l’azienda ha prodotto avatar generati dall’intelligenza artificiale, ma oggi lancia una nuova generazione, la prima che sfrutta i più recenti progressi dell’intelligenza artificiale generativa, e sono più realistici ed espressivi di qualsiasi cosa abbia mai visto. Sebbene il lancio di oggi significhi che quasi tutti saranno in grado di creare un sosia digitale, in questo pomeriggio di inizio aprile, prima che la tecnologia diventi pubblica, hanno accettato di creare un mio sosia.

Quando finalmente arrivo nell’elegante studio dell’azienda nell’East London, vengo accolta da Tosin Oshinyemi, responsabile della produzione dell’azienda. Mi guiderà e mi indirizzerà nel processo di raccolta dei dati – e per “raccolta dei dati” intendo l’acquisizione dei miei tratti facciali, dei miei modi di fare e altro ancora – proprio come fa normalmente per gli attori e i clienti di Synthesia.

SYNTHESIA

Mi presenta uno stylist e un truccatore in attesa e io mi maledico per aver perso così tanto tempo a prepararmi. Il loro compito è quello di assicurarsi che le persone abbiano il tipo di abbigliamento che possa apparire bene alla telecamera e che siano coerenti da una ripresa all’altra. La stylist mi dice che il mio abbigliamento va bene (fiuuu) e la truccatrice mi ritocca il viso e mette in ordine i miei peli di bambino. Il camerino è decorato con centinaia di polaroid sorridenti di persone che sono state clonate digitalmente prima di me.

A parte il piccolo supercomputer che gira nel corridoio e che elabora i dati generati nello studio, sembra di entrare in uno studio giornalistico piuttosto che in una fabbrica di deepfake.

Scherzo sul fatto che Oshinyemi ha quello che MIT Technology Review potrebbe definire un titolo di lavoro del futuro: “Direttore della creazione di deepfake”.

“Ci piace il termine ‘media sintetici’ in contrapposizione a ‘deepfake'”, afferma.

Si tratta di una sottile ma, secondo alcuni, notevole differenza semantica. Entrambi indicano video o registrazioni audio generate dall’intelligenza artificiale di persone che fanno o dicono qualcosa che non è necessariamente accaduto nella vita reale. Ma i deepfake hanno una cattiva reputazione. Da quando sono stati creati, quasi dieci anni fa, il termine è diventato sinonimo di qualcosa di non etico, afferma Alexandru Voica, responsabile degli affari e delle politiche aziendali di Synthesia. Pensate a contenuti sessuali prodotti senza consenso o alle campagne politiche che diffondono disinformazione o propaganda.

“I media sintetici sono la versione più benevola e produttiva di tutto ciò”, sostiene. E Synthesia vuole offrire la versione migliore di questa versione.

Finora, tutti i video di persone generati dall’intelligenza artificiale tendevano a presentare una certa rigidità, un’irregolarità o altri elementi innaturali che li rendevano facilmente distinguibili dalla realtà. Essendo così vicini alla realtà, ma non del tutto, questi video possono far sentire le persone infastidite o a disagio: un fenomeno comunemente noto come “uncanny valley”. Synthesia sostiene che la sua nuova tecnologia ci porterà finalmente fuori da questa valle.

Grazie ai rapidi progressi dell’intelligenza artificiale generativa e a una marea di dati di addestramento creati da attori umani che sono stati inseriti nel suo modello di intelligenza artificiale, Synthesia è stata in grado di produrre avatar che sono effettivamente più simili agli esseri umani e più espressivi dei loro predecessori. I cloni digitali sono in grado di adeguare meglio le loro reazioni e la loro intonazione al sentimento dei loro copioni: ad esempio, si comportano in modo più allegro quando parlano di cose felici e in modo più serio o triste quando parlano di cose spiacevoli. Riescono anche a far corrispondere meglio le espressioni facciali, i piccoli movimenti che possono parlare per noi senza le parole.

Ma questo progresso tecnologico segnala anche un cambiamento sociale e culturale molto più ampio. Sempre più spesso, gran parte di ciò che vediamo sui nostri schermi è generato (o almeno manipolato) dall’intelligenza artificiale e diventa sempre più difficile distinguere ciò che è reale da ciò che non lo è. Questo minaccia la nostra fiducia in tutto ciò che vediamo, con conseguenze molto reali e pericolose.

“Penso che potremmo dover dire addio alla possibilità di scoprire la verità in modo rapido”, afferma Sandra Wachter, docente dell’Oxford Internet Institute, che si occupa di ricerca sulle implicazioni legali ed etiche dell’IA. “L’idea che basti cercare qualcosa su Google per sapere cosa è realtà e cosa è finzione non credo funzioni più”.

Se da un lato ero entusiasta che Synthesia potesse creare il mio doppio digitale, dall’altro mi sono chiesta se la distinzione tra media sintetici e deepfakes sia fondamentalmente priva di significato. Anche se i primi centrano l’intento del creatore e, criticamente, il consenso del soggetto, c’è davvero un modo per creare avatar AI in modo sicuro se il risultato finale è lo stesso? E vogliamo davvero uscire dalla valle del mistero se ciò significa che non possiamo più afferrare la verità?

Ma più urgentemente, era il momento di scoprire cosa si prova a vedere una versione post-verità di se stessi.

Quasi reale

Un mese prima del mio viaggio in studio, sono andata a trovare il CEO di Synthesia Victor Riparbelli nel suo ufficio vicino a Oxford Circus. Come racconta Riparbelli, la storia di Synthesia nasce dalle sue esperienze di esplorazione della musica techno d’avanguardia e geek durante la sua infanzia in Danimarca. Internet gli ha permesso di scaricare software e di produrre le proprie canzoni senza dover acquistare costosi sintetizzatori.

“Credo molto nella possibilità di dare alle persone la possibilità di esprimersi nel modo in cui possono, perché penso che questo crei un mondo più meritocratico”, mi dice.

Ha visto la possibilità di fare qualcosa di simile con i video quando si è imbattuto in una ricerca sull’uso del deep learning per trasferire le espressioni da un volto umano a un altro sullo schermo.

“È stata la prima volta che una rete di deep learning è riuscita a produrre fotogrammi video che sembravano reali”, spiega l’autore.

La ricerca è stata condotta da Matthias Niessner, professore presso l’Università Tecnica di Monaco di Baviera, che ha co-fondato Synthesia con Riparbelli nel 2017, insieme alla professoressa dell’University College di Londra Lourdes Agapito e a Steffen Tjerrild, con cui Riparbelli aveva precedentemente lavorato a un progetto di criptovaluta.

Inizialmente l’azienda costruiva strumenti per la sincronizzazione labiale e il doppiaggio per l’industria dell’intrattenimento, ma si è resa conto che la qualità di questa tecnologia era molto alta e non c’era molta richiesta. Nel 2020 Synthesia ha cambiato direzione e ha lanciato la sua prima generazione di avatar AI per i clienti aziendali. Questa svolta ha dato i suoi frutti. Nel 2023, Synthesia ha raggiunto lo status di unicorno, ovvero è stata valutata più di 1 miliardo di dollari: è una delle poche aziende europee di IA ad averlo raggiunto.

La prima generazione di avatar aveva un aspetto goffo, con movimenti in loop e poche variazioni. Le iterazioni successive hanno iniziato ad avere un aspetto più umano, ma facevano ancora fatica a pronunciare parole complicate e le cose erano leggermente fuori sincrono.

La sfida è che le persone sono abituate a guardare i volti degli altri. “Noi esseri umani sappiamo cosa fanno i veri esseri umani”, afferma Jonathan Starck, CTO di Synthesia. Fin dall’infanzia, “siamo davvero sintonizzati sulle persone e sui volti. Si sa cosa è giusto, quindi tutto ciò che non è giusto salta all’occhio”.

Questi primi video generati dall’intelligenza artificiale, come i deepfake in generale, sono stati realizzati utilizzando le reti generative avversarie, o GAN, una vecchia tecnica per la generazione di immagini e video che utilizza due reti neurali che giocano l’una con l’altra. Si trattava di un processo laborioso e complicato e la tecnologia era instabile.

Ma nel boom dell’AI generativa dell’ultimo anno circa, l’azienda ha scoperto di poter creare avatar molto migliori utilizzando reti neurali generative che producono una qualità superiore in modo più costante. Più dati vengono forniti a questi modelli, meglio imparano. A tale scopo, Synthesia utilizza sia modelli linguistici di grandi dimensioni che modelli di diffusione; i primi aiutano gli avatar a reagire allo script, mentre i secondi generano i pixel.

Nonostante il salto di qualità, l’azienda non si rivolge ancora all’industria dell’intrattenimento. Synthesia continua a considerarsi una piattaforma per le aziende. La sua scommessa è questa: poiché le persone passano più tempo a guardare video su YouTube e TikTok, ci sarà una maggiore domanda di contenuti video. I giovani stanno già saltando la ricerca tradizionale e si rivolgono a TikTok per ottenere informazioni presentate in forma di video. Riparbelli sostiene che la tecnologia di Synthesia potrebbe aiutare le aziende a convertire le loro noiose comunicazioni aziendali, le relazioni e i materiali di formazione in contenuti che le persone guardano e con cui si impegnano. Suggerisce inoltre che potrebbe essere utilizzata per creare materiali di marketing.

Egli sostiene che la tecnologia di Synthesia è utilizzata dal 56% delle aziende Fortune 100, la maggior parte delle quali la usa per la comunicazione interna. L’azienda annovera tra i suoi clienti Zoom, Xerox, Microsoft e Reuters. I servizi partono da 22 dollari al mese.

L’azienda spera che questo sia un’alternativa più economica ed efficiente ai video di una società di produzione professionale, e che possa essere quasi indistinguibile da essi. Riparbelli mi ha detto che i suoi nuovi avatar potrebbero facilmente ingannare una persona facendole credere di essere reali.

“Penso che siamo al 98%”, dice.

Nel bene o nel male, sto per vederlo con i miei occhi.

Non essere spazzatura

Nella ricerca sull’intelligenza artificiale, c’è un detto: garbage in, garbage out. Se i dati utilizzati per addestrare un modello di intelligenza artificiale sono spazzatura, ciò si rifletterà nei risultati del modello. Più il modello AI ha catturato dati dei miei movimenti facciali, delle microespressioni, delle inclinazioni della testa, degli ammiccamenti, delle alzate di spalle e dei gesti delle mani, più realistico sarà l’avatar.

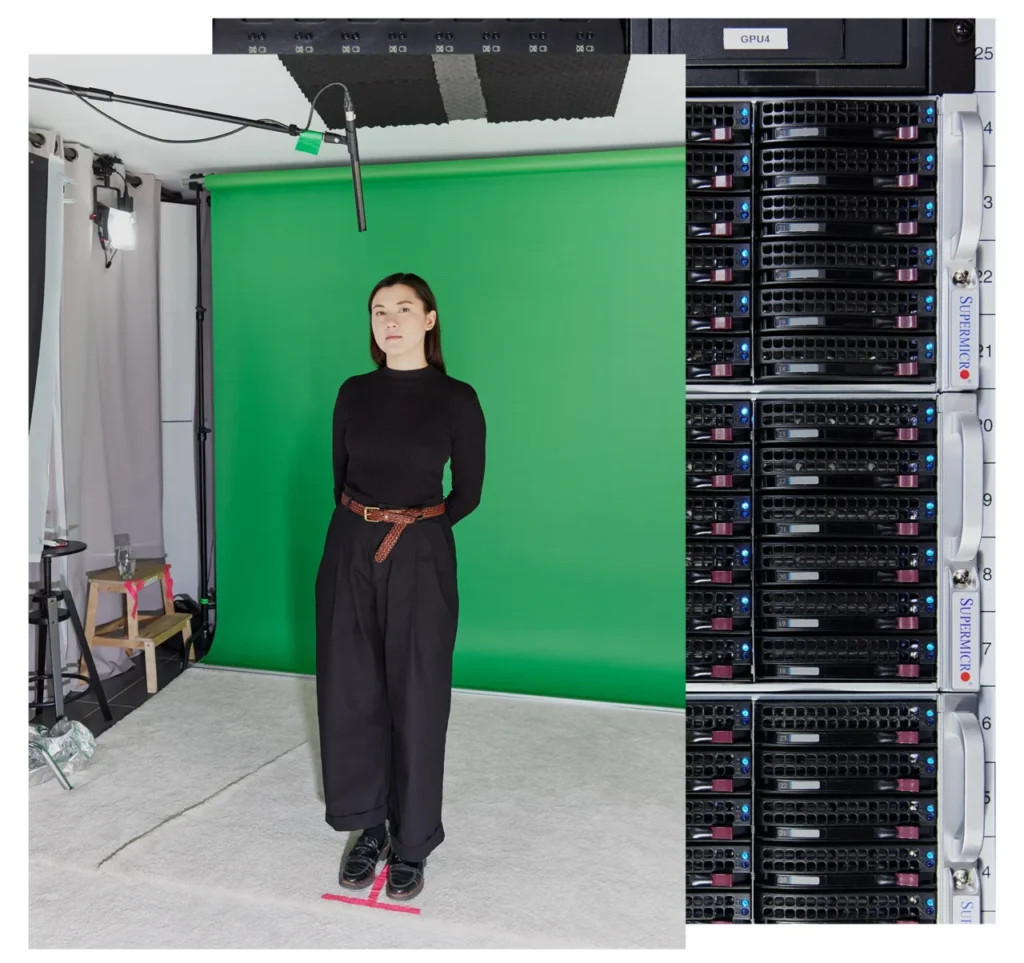

Tornato in studio, mi sto sforzando di non essere spazzatura. Sono in piedi davanti a uno schermo verde e Oshinyemi mi guida nel processo di calibrazione iniziale, in cui devo muovere la testa e gli occhi con un movimento circolare. A quanto pare, questo permetterà al sistema di capire i miei colori naturali e i tratti del viso. Mi viene poi chiesto di pronunciare la frase “Tutti i ragazzi hanno mangiato un pesce”, per catturare tutti i movimenti della bocca necessari a formare vocali e consonanti. Vengono anche effettuate riprese di me che “ozio” in silenzio.

Poi mi chiede di leggere un copione per uno YouTuber fittizio con toni diversi, indirizzandomi sullo spettro di emozioni che dovrei trasmettere. Prima dovrei leggerlo in modo neutro e informativo, poi in modo incoraggiante, in modo infastidito e lamentoso e infine in modo eccitato e convincente.

“Ciao a tutti, bentornati a Elevate Her con la vostra conduttrice, Jess Mars. È bello avervi qui. Stiamo per affrontare un argomento piuttosto delicato e che, onestamente, ci tocca da vicino: la gestione delle critiche nel nostro cammino spirituale”, leggo dal gobbo, cercando contemporaneamente di visualizzare il mio interlocutore mentre si lamenta. “Non importa dove si guardi, sembra che ci sia sempre una voce critica pronta a intervenire, non è vero?”.

Non essere spazzatura, non essere spazzatura, non essere spazzatura.

“È stato davvero bello. Lo stavo guardando e ho pensato: “Beh, è vero. Si sta sicuramente lamentando”, dice Oshinyemi, incoraggiante. La prossima volta, magari, aggiungete un po’ di giudizio, suggerisce.

Giriamo diverse riprese con diverse varianti del copione. In alcune versioni mi è permesso di muovere le mani. In altre, Oshinyemi mi chiede di tenere uno spillo di metallo tra le dita. Questo per testare i “bordi” delle capacità della tecnologia quando si tratta di comunicare con le mani, dice Oshinyemi. Storicamente, rendere naturali gli avatar dell’intelligenza artificiale e far corrispondere i movimenti della bocca al parlato è stata una sfida molto difficile, afferma David Barber, professore di apprendimento automatico presso l’University College di Londra che non è coinvolto nel lavoro di Synthesia. Questo perché il problema va ben oltre i movimenti della bocca; bisogna pensare alle sopracciglia, a tutti i muscoli del viso, alle scrollate di spalle e ai numerosi piccoli movimenti che gli esseri umani usano per esprimersi.

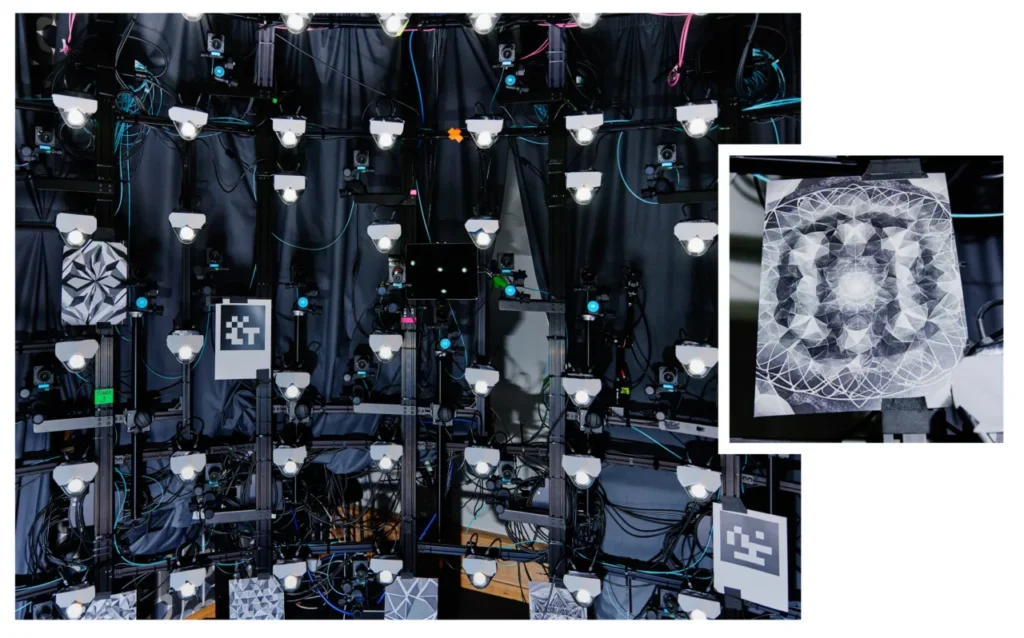

Synthesia lavora con gli attori per addestrare i suoi modelli dal 2020 e i loro sosia costituiscono i 225 avatar di riserva che i clienti possono animare con i loro script. Ma per addestrare la sua ultima generazione di avatar, Synthesia aveva bisogno di più dati; nell’ultimo anno ha lavorato con circa 1.000 attori professionisti a Londra e New York. (Synthesia afferma di non vendere i dati raccolti, anche se ne rilascia alcuni per scopi di ricerca accademica).

In precedenza gli attori venivano pagati ogni volta che il loro avatar veniva utilizzato, ma ora l’azienda paga loro una somma anticipata per addestrare il modello di intelligenza artificiale. Synthesia utilizza i loro avatar per tre anni, dopodiché agli attori viene chiesto se vogliono rinnovare il contratto. In caso affermativo, vengono in studio per creare un nuovo avatar. In caso contrario, l’azienda cancellerà i loro dati. I clienti aziendali di Synthesia possono anche generare i propri avatar personalizzati mandando qualcuno in studio a fare gran parte di quello che sto facendo io.

DAVID VINTINER

Tra una ripresa e l’altra, il truccatore viene a fare qualche ritocco per assicurarsi che io abbia lo stesso aspetto in ogni ripresa. Mi sento arrossire per le luci dello studio, ma anche per la recitazione. Dopo che il team ha raccolto tutte le inquadrature necessarie per catturare le mie espressioni facciali, scendo al piano di sotto per leggere altro testo ad alta voce per i campioni vocali.

Questo processo richiede che io legga un passaggio in cui dichiaro di acconsentire esplicitamente alla clonazione della mia voce, che potrà essere utilizzata sull’account di Voica sulla piattaforma Synthesia per generare video e discorsi.

Il consenso è fondamentale

Questo processo è molto diverso dal modo in cui vengono creati molti avatar dell’intelligenza artificiale, deepfakes o media sintetici, comunque li si voglia chiamare.

La maggior parte dei deepfakes non viene creata in studio. Gli studi hanno dimostrato che la stragrande maggioranza dei deepfakes online è costituita da contenuti sessuali non consensuali, di solito utilizzando immagini rubate dai social media. L’intelligenza artificiale generativa ha reso la creazione di questi deepfakes facile ed economica e negli Stati Uniti e in Europa si sono verificati diversi casi molto seri di bambini e donne abusati in questo modo. Gli esperti hanno anche lanciato l’allarme che la tecnologia possa essere usata per diffondere disinformazione politica, una minaccia particolarmente grave visto il numero record di elezioni che si terranno quest’anno in tutto il mondo.

La politica di Synthesia è di non creare avatar di persone senza il loro esplicito consenso. Ma non è stata immune da abusi. L’anno scorso, alcuni ricercatori hanno scoperto che la disinformazione a favore della Cina era stata creata utilizzando gli avatar di Synthesia e confezionata come notizia, il che, secondo l’azienda, violava i suoi termini di servizio.

Da allora, l’azienda ha introdotto sistemi di verifica e moderazione dei contenuti più rigorosi. Applica una filigrana con informazioni su dove e come sono stati creati i video dell’avatar dell’IA. Mentre prima aveva quattro moderatori di contenuti interni, ora le persone che svolgono questo lavoro sono il 10% del suo staff di 300 persone. L’azienda ha anche assunto un ingegnere per costruire migliori sistemi di moderazione dei contenuti basati sull’intelligenza artificiale. Questi filtri aiutano Synthesia a controllare ogni singola cosa che i suoi clienti cercano di generare. Tutto ciò che è sospetto o ambiguo, come ad esempio i contenuti sulle criptovalute o sulla salute sessuale, viene trasmesso ai moderatori umani. Synthesia tiene anche un registro di tutti i video creati dal suo sistema.

Sebbene chiunque possa entrare a far parte della piattaforma, molte funzioni non sono disponibili finché non si passa attraverso un sistema di controllo approfondito, simile a quello utilizzato dal settore bancario, che comprende il colloquio con il team di vendita, la firma di contratti legali e la sottoposizione a controlli di sicurezza, spiega Voica. I clienti base sono limitati a produrre contenuti strettamente fattuali, mentre solo i clienti aziendali che utilizzano avatar personalizzati possono generare contenuti contenenti opinioni. Inoltre, solo le organizzazioni giornalistiche accreditate possono creare contenuti di attualità.

“Non possiamo pretendere di essere perfetti. Se le persone ci segnalano qualcosa, prendiamo provvedimenti rapidi, come il divieto o la limitazione di individui o organizzazioni”, afferma Voica. Ma ritiene che queste misure funzionino da deterrente, il che significa che la maggior parte dei malintenzionati si rivolgerà invece a strumenti open-source liberamente disponibili.

Metto alla prova alcuni di questi limiti quando vado nell’ufficio di Synthesia per la fase successiva del processo di generazione del mio avatar. Per creare i video che avranno come protagonista il mio avatar, devo scrivere una sceneggiatura. Utilizzando l’account di Voica, decido di usare brani dell’Amleto, oltre a precedenti articoli che ho scritto. Utilizzo anche una nuova funzione della piattaforma Synthesia, un assistente AI che trasforma qualsiasi link web o documento in un copione già pronto. Cerco di far leggere al mio avatar le notizie sulle nuove sanzioni dell’Unione Europea contro l’Iran.

Voica mi manda subito un sms: “Mi hai messo nei guai!”.

Il sistema ha segnalato il suo account per aver cercato di generare contenuti soggetti a restrizioni.

PER GENTILE CONCESSIONE DI SYNTHESIA

Offrire servizi senza queste restrizioni sarebbe “una grande strategia di crescita”, brontola Riparbelli. Ma “in definitiva, abbiamo regole molto severe su ciò che si può creare e ciò che non si può creare. Pensiamo che il modo giusto per introdurre queste tecnologie nella società sia quello di essere un po’ più restrittivi all’inizio”.

Tuttavia, anche se queste protezioni funzionassero perfettamente, il risultato finale sarebbe comunque un Internet in cui tutto è falso. E il mio esperimento mi fa pensare a come potremmo prepararci.

Il nostro panorama informativo sembra già molto torbido. Da un lato, c’è una maggiore consapevolezza da parte dell’opinione pubblica del fatto che i contenuti generati dall’intelligenza artificiale stanno fiorendo e potrebbero essere un potente strumento di disinformazione. Dall’altro, però, non è ancora chiaro se i deepfakes siano utilizzati per la disinformazione su scala e se stiano spostando l’ago della bilancia per cambiare le credenze e i comportamenti delle persone.

Se le persone diventano troppo scettiche nei confronti dei contenuti che vedono, potrebbero smettere di credere in qualsiasi cosa, il che potrebbe consentire ai cattivi attori di approfittare di questo vuoto di fiducia e mentire sull’autenticità dei contenuti reali. I ricercatori hanno definito questo fenomeno il “dividendo del bugiardo“. Essi avvertono che i politici, ad esempio, potrebbero affermare che le informazioni realmente incriminanti sono false o create con l’IA.

Claire Leibowicz, responsabile dell’integrità dell’IA e dei media presso l’organizzazione no-profit Partnership on AI, afferma di temere che la crescente consapevolezza di questa lacuna renderà più facile “negare in modo plausibile e mettere in dubbio materiale o media reali come prove in molti contesti diversi, non solo nelle notizie, [ma] anche nei tribunali, nell’industria dei servizi finanziari e in molte delle nostre istituzioni”. Mi dice di essere rincuorata dalle risorse che Synthesia ha dedicato alla moderazione dei contenuti e al consenso, ma afferma che questo processo non è mai impeccabile.

Anche Riparbelli ammette che, a breve termine, la proliferazione di contenuti generati dall’IA probabilmente causerà problemi. Sebbene le persone siano state addestrate a non credere a tutto ciò che leggono, tendono ancora a fidarsi di immagini e video, aggiunge. Secondo Riparbelli, le persone devono testare personalmente i prodotti di intelligenza artificiale per vedere cosa è possibile fare e non dovrebbero fidarsi di ciò che vedono online a meno che non lo abbiano verificato.

Senza contare che la regolamentazione dell’IA è ancora frammentaria e che gli sforzi del settore tecnologico per verificare la provenienza dei contenuti sono ancora in fase iniziale. I consumatori, con i loro diversi gradi di alfabetizzazione mediatica, possono davvero combattere l’ondata crescente di contenuti dannosi generati dall’IA con azioni individuali?

Attenzione, PowerPoint

Il giorno successivo alla mia ultima visita, Voica mi invia per e-mail i video con il mio avatar. Quando inizia la riproduzione del primo, sono colta di sorpresa. È doloroso come vedersi in una telecamera o sentire una registrazione della propria voce. Poi mi riprendo. All’inizio pensavo che l’avatar fosse me.

Più guardo i video di “me stessa” e più mi sento in bilico. Davvero socchiudo gli occhi così tanto? Sbatto le palpebre così tanto? E muovo la mascella in quel modo? Gesù.

È buono. È davvero buono. Ma non è perfetto. “Un’animazione stranamente buona”, mi scrive il mio collega.

“Ma la voce a volte sembra esattamente come te, altre volte ha un accento americano generico e con un tono strano”, aggiunge. “Strano da morire”.

Ha ragione. La voce a volte è la mia, ma nella vita reale sono più umm e ahh. La cosa notevole è che ha colto un’irregolarità nel mio modo di parlare. Il mio accento è un pasticcio transatlantico, confuso da anni trascorsi nel Regno Unito, guardando la TV americana e frequentando una scuola internazionale. Il mio avatar a volte pronuncia la parola “robot” con accento britannico e altre volte con accento americano. È una cosa che probabilmente nessun altro noterebbe. Ma l’IA l’ha fatto.

Anche la gamma di emozioni del mio avatar è limitata. Il discorso di Shakespeare “Essere o non essere” viene pronunciato in modo molto semplice. L’avevo guidato a essere furioso quando ha letto un articolo che ho scritto sui deepfakes di nudo non consensuale di Taylor Swift; l’avatar si lamenta e giudica, certo, ma non è arrabbiato.

Non è la prima volta che mi faccio soggetto di prova per una nuova IA. Non molto tempo fa, ho provato a generare immagini di me stessa come avatar dell’IA, ottenendo solo un mucchio di nudi. Quell’esperienza è stata un esempio sconvolgente di quanto possano essere distorti i sistemi di intelligenza artificiale. Ma questa esperienza – e questo particolare modo di essere immortalati – era decisamente di un altro livello.

Carl Öhman, professore assistente all’Università di Uppsala che ha studiato i resti digitali ed è autore di un nuovo libro, The Afterlife of Data, chiama gli avatar come quelli che ho realizzato “cadaveri digitali”.

“È identico a te, ma non c’è nessuno in casa”, dice. “Sarebbe l’equivalente di clonare voi, ma il vostro clone è morto. E poi si anima il cadavere, in modo che si muova e parli, con impulsi elettrici”.

È più o meno così che ci si sente. Le piccole sfumature in cui non mi riconosco sono sufficienti a scoraggiarmi. D’altra parte, l’avatar potrebbe ingannare chiunque non mi conosca bene. L’assistente virtuale AI riassume la lunga lettura in un breve video decente, che viene narrato dal mio avatar. Non è Shakespeare, ma è meglio di molte presentazioni aziendali a cui ho dovuto assistere. Penso che se dovessi usarlo per consegnare una relazione di fine anno ai miei colleghi, forse questo livello di autenticità sarebbe sufficiente.

E questo è il punto di forza, secondo Riparbelli: “Quello che facciamo è più simile a PowerPoint che a Hollywood”.

L’ultima generazione di avatar non è certo pronta per il grande schermo. Sono ancora bloccati in modalità ritratto e mostrano l’avatar solo frontalmente e dalla vita in su. Ma in un futuro non troppo lontano, dice Riparbelli, l’azienda spera di creare avatar in grado di comunicare con le mani e di conversare tra loro. Sta anche progettando avatar a corpo intero che possano camminare e muoversi in uno spazio generato da una persona. (L’impianto per abilitare questa tecnologia esiste già; infatti è dove mi trovo io nell’immagine in cima a questo pezzo).

Ma lo vogliamo davvero? Sembra un futuro cupo in cui gli esseri umani consumano contenuti generati dall’IA e presentati loro da avatar generati dall’IA e usano l’IA per riconfezionarli in altri contenuti, che probabilmente verranno scartati per generare altra IA. Se non altro, questo esperimento mi ha chiarito che il settore tecnologico ha urgentemente bisogno di intensificare le pratiche di moderazione dei contenuti e di garantire che le tecniche di provenienza dei contenuti, come il watermarking, siano solide.

Anche se la tecnologia e la moderazione dei contenuti di Synthesia non sono ancora perfette, sono nettamente migliori di tutto ciò che ho visto prima nel campo, e questo dopo solo un anno o poco più dall’attuale boom dell’IA generativa. Lo sviluppo dell’IA si muove a rotta di collo ed è allo stesso tempo eccitante e scoraggiante pensare a come saranno gli avatar generati dall’IA tra pochi anni. Forse in futuro dovremo adottare parole d’ordine per indicare che stiamo comunicando con un vero essere umano e non con un’IA.

Ma quel giorno non è oggi.

Ho trovato stranamente confortante che in uno dei video il mio avatar sproloquiasse sui deepfakes non consensuali e dicesse, con voce sociopatica e felice, “I giganti della tecnologia? Oh! Stanno facendo una strage!”.

Io non lo farei mai.

Foto di copertina: in un futuro non troppo lontano, Synthesia spera di creare avatar a corpo intero che possano camminare e muoversi in uno spazio generato da una persona.

DAVID VINTINER